Dopo aver letto il mio precedente articolo, sull’aspect ratio e le misure dei filmati in pixel per home e cinema immagino un grande entusiasmo per tutti, pensando che basti niente per poter portare i propri filmati sul grande schermo. Diciamo che quella era solo una mezza verità, perchè abbiamo parlato di pixel, e delle informazioni con cui sono fatti i filmati per il grande schermo e per il (relativamente) piccolo schermo. Tutto vero, per quanto riguarda il prodotto finale, ma spesso i numeri non corrispondono alle informazioni catturate dai sensori o massaggiate nei vari passaggi tra DI editing e postproduzione.

Dopo aver letto il mio precedente articolo, sull’aspect ratio e le misure dei filmati in pixel per home e cinema immagino un grande entusiasmo per tutti, pensando che basti niente per poter portare i propri filmati sul grande schermo. Diciamo che quella era solo una mezza verità, perchè abbiamo parlato di pixel, e delle informazioni con cui sono fatti i filmati per il grande schermo e per il (relativamente) piccolo schermo. Tutto vero, per quanto riguarda il prodotto finale, ma spesso i numeri non corrispondono alle informazioni catturate dai sensori o massaggiate nei vari passaggi tra DI editing e postproduzione.

Definiamo cos’è a livello teorico il FullHD

Il fullHD è una combinazione di pixel che forma un video di 1920 pixel in larghezza x 1080 pixel in lunghezza.

Il problema nasce dal fatto che non si deve considerare solo il file registrato, ma è fondamentale verificare come si creano e si campionano queste informazioni, perchè la maggioranza dei sensori delle camere (sopratto nel consumer e prosumer, ma anche in molte pro) non hanno neanche un numero sufficiente di pixel per coprire quel numero di pixel e vengono raggiunti con “trucchi tecnici” come il pixel shifting, il sovracampionamento etc etc

Per cui spesso le camere hanno un numero diverso (spesso minore) di pixel e quei numeri li raggiungono artificialmente.

Quindi si parla di immagini meno definite di quello che realmente dovrebbero descrivere quel numero di punti.

Una camera ideale ha uno o tre sensori in formato FULLHD, ovvero a misura 1920 x 1080, mentre quando si usano sensori più grandi (HDSLR) la tecnica di scalatura da un numero maggiore di pixel è fondamentale per non introdurre difetti e/o perdita di definizione.

Il discorso è molto semplice, se abbiamo troppe informazioni, una parte va scartata, se però la tecnica è sbagliata, la caduta di qualità è grande e quindi si creano dei difetti.

Per ottimizzare la registrazione video delle informazioni raccolte dai sensori le diverse case produttrici utilizzano tecniche diverse, con diversi svantaggi:

– si catturano solo parti della colorimetria (campionamento 4:2:2 o 4:2:0)

– si comprimono le informazioni (introducendo artefatti)

– si perde parte della nitidezza nel tentativo di ridurre le dimensioni del file

di contro come vantaggi :

– il peso cambia, i file passano da 11.2 giga al minuto (file non compresso) a 350 mb al minuto.

– i buffer e i supporti su cui salvare i girati sono più parchi di richieste e quindi più economici da realizzare

– le macchine sono più agili e compatte, quindi permettono l’uso di camere anche in situazioni molto costrette e rischiose.

– si è teoricamente “democratizzato” la produzione di filmati di qualità più “cinematografica”, per chi il knowhow su come usarle.

La camera lavora in FULLHD, ma come?

Ora vanno tanto di moda le HDSLR, perchè si dice che abbiano “l’effetto cinema” inside (ne parleremo in futuro di questa illusione), si riprende in FULLHD, teorico, ovvero il file che salviamo ha quel formato, ma a seconda delle macchine il sensore cattura in modo diverso le immagini, più o meno bene, più meno dettagliate e/o nitide.

Ora vanno tanto di moda le HDSLR, perchè si dice che abbiano “l’effetto cinema” inside (ne parleremo in futuro di questa illusione), si riprende in FULLHD, teorico, ovvero il file che salviamo ha quel formato, ma a seconda delle macchine il sensore cattura in modo diverso le immagini, più o meno bene, più meno dettagliate e/o nitide.

Essendo una persona pratica non citerò una o l’altra marca, ma le tecnologie usate, come funzionano e quali sono i risultati in funzione del nostro scopo: avere immagini migliori.

Le HDSLR sono usate perchè sono dotate sensori più grandi delle classiche telecamere, quindi offrono immagini più luminose a parità di lente, DOF più comprimibile per staccare i soggetti dallo sfondo, un contrasto minore che aiuta la postproduzione.

Il vantaggio del sensore grande è un difetto per altri motivi, perchè il sensore CMOS soffre di un difetto chiamato rolling shutter, quindi più è grande il sensore e più si accentua il difetto nelle riprese in movimento, soprattutto sui movimenti circolari.

In questo video è possibile vedere come il rolling shutter alteri gli elementi in rotazione.

in questo video è possibile vedere il confronto tra il rolling shutter lineare tra due sensori diversi (aps-c e FullFrame).

Da notare come a parità di movimento più è grande il sensore (full frame) più i palazzi si inclinano e sembrano fatti di gelatina in movimento.

Il rolling shutter è parzialmente corregibile in post (quello lineare) mentre per quello circolare si può sperare nei miracoli…

Quando è troppo…

Altro problema non banale di usare sensori fotografici è la scalatura… perchè non abbiamo i pixel del fullHD, ne abbiamo un sacco in più… il fullHD è circa 2 mpixel, sulle HDSLR quando va male sono 16, il che non è sempre un vantaggio…

Le HDSLR utilizzano principalmente due tecniche di scalatura dell’immagine : line skipping e pixel binning.

Line Skipping

Il line skipping è la tecnica più vecchia, che oggi dovrebbe essere considerata obsoleta, ma quando naque 6 anni fà era gestibile.

Come funziona?

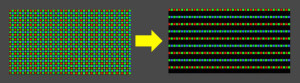

Semplice, abbiamo 4000 linee? ce ne bastano solo 1080? va bene allora prendiamo una linea, ne scartiamo un certo numero, poi ne prendiamo un’altra e via così fino alla fine del sensore. Naturalmente tenendo conto della struttura del sensore di Bayer, quindi come potete vedere nell’immagine laterale le informazioni catturate rispetto al sensore originale sono decisamente poche e ben distanziate.. che porta diversi problemi.

Vantaggi :

– veloce

– semplice da effettuare

– non richiede potenza processore e rapido da gestire nel salvataggio

Svantaggi :

– prendendo solo una parte delle informazioni si perde definizione

– si hanno artefatti come aliasing (seghettature sulle immagini)

– moires (causato dal campionamento causale delle linee)

– flickering delle linee sottili (perchè sono viste nelle linee catturate in alcuni fotogrammi e in altri no)

Pixel Binning

La seconda tecnica è il Pixel binning, è più efficace perchè usa tutti i pixel del sensore, non scarta nulla, e per creare i filmati fa un downsampling di tutte le informazioni.

In questo modo evita TUTTI i problemi del line skipping, senza introdurre altri problemi.

Questa tecnica è una introduzione recente nelle HDSLR e applicata solo da alcune case produttrici perchè richiede un processore interno alla camera molto più potente, buffer più grandi per gestire tutto il flusso informazioni e la successiva campionatura per il formato FullHD.

Il campionamento colore, cos’è e perchè ci preoccupa?

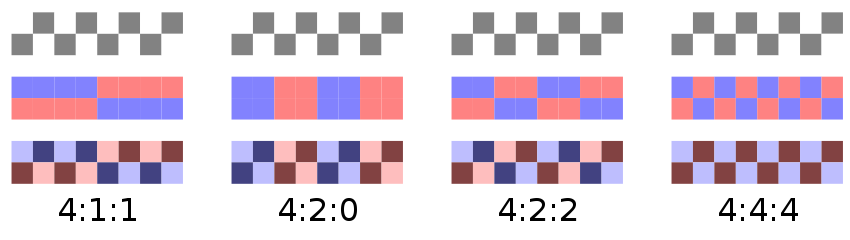

Le macchine professionali campionano le informazioni colore con il campionamento definito 4:4:4, ovvero per ogni gruppo di pixel si catturano e registrano tutte le informazioni colore e luminosità. Le macchine prosumer lavorano con un campionamento colore inferiore, dal 4:2:2 al 4:2:0. Il campionamento colore inferiore, spesso non è percepibile sul filmato originale, ma se girato nei limiti della qualità registrabile, o se viene pesantemente postprodotto può mostrare i suoi limiti e/o una maggior limitazione nella sua lavorabilità.

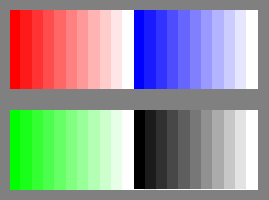

Senza annoiare con troppi concetti tecnici, le tre cifre fanno riferimento la prima alla luminanza del filmato, quindi ogni informazione di luminosità dei pixel viene campionata e catturata, le seconde due cifre fanno riferimento al campionamento del blu e del rosso. Nell’immagine sottostante vedete una rappresentazione grafica di tale campionamento. quindi abbiamo una portante più stabile e dettagliata nella luminanza, mentre se dobbiamo manipolare il colore sul blu e sul rosso abbiamo meno informazioni, il che si può trasformare in artefatti o difetti sul filmato finale.

quindi abbiamo una portante più stabile e dettagliata nella luminanza, mentre se dobbiamo manipolare il colore sul blu e sul rosso abbiamo meno informazioni, il che si può trasformare in artefatti o difetti sul filmato finale.

Attenzione al verbo usato, il condizionale, perchè non è detto che il filmato, se trattato con cautela, e correttamente, generi difetti o problemi. Sicuramente un filmato campionato in origine a 4:2:0 fornirà un livello di manipolabilità inferiore ad un filmato 4:4:4. Ma questo non è un limite, perchè nei film sul grande schermo si usano contributi e materiali da diverse fonti, spesso le pubblicità prima dei film sono girate in fullhd, in tanti formati diversi, e non sempre si notano le differenze.

Concludendo

Quindi noi abbiamo degli strumenti che registrano dei filmati 1920 x 1080, ma non abbiamo la conferma che abbiano catturato realmente quella griglia di informazioni, anzi nella maggior parte dei casi abbiamo la certezza che ne hanno catturato solo una minima parte di quelli che ci servono, sia a livello di definizione che di colore.

Per questo motivo ho scritto che il formato FullHD è si molto vicino a livello matematico a quello del formato cinematografico, ma non è detto che siano caratteristiche sufficienti per avere una immagine pronta per il grande schermo.

Senza fasciarsi la testa e scartare tutti gli strumenti a priori, ricordiamo come ci siano molti film girati con mezzi più umili come la pellicola 16 mm, oppure film più recenti girati in dvcam (28 giorni dopo, di danny boyle). E in tanti blockbusters ci sono molte sequenze girate con HDSLR, ma vi sfido ad inviduarle in mezzo agli altri stacchi. Quindi si può riprendere e lavorando con cura i propri filmati portarli sul grande schermo, ma da qui a dire che siano la stessa cosa che usare macchine da presa professionali …

Buona luce a tutti!

Oggi purtroppo dato che i cavi usb-C sono diventati standard per la ricarica dei ccellulari e altri apparecchi, ci hanno riempito di cablaggi magari decenti per la ricarica, o la ricarica veloce, ma come cablaggi dati sono alquanto scarsi, per cui lo spessore che vediamo probabilmente è dato da un cavo per la ricarica più importante, per non fare resistenza, perchè non c’è tempo per aspettare di ricaricare il proprio smartphone, ma quando lo usiamo per copiare dei dati… è sicuramente colpa del dispositivo, non del cavo… tanto ricarica veloce, lo sappiamo che è veloce di tutto…

Oggi purtroppo dato che i cavi usb-C sono diventati standard per la ricarica dei ccellulari e altri apparecchi, ci hanno riempito di cablaggi magari decenti per la ricarica, o la ricarica veloce, ma come cablaggi dati sono alquanto scarsi, per cui lo spessore che vediamo probabilmente è dato da un cavo per la ricarica più importante, per non fare resistenza, perchè non c’è tempo per aspettare di ricaricare il proprio smartphone, ma quando lo usiamo per copiare dei dati… è sicuramente colpa del dispositivo, non del cavo… tanto ricarica veloce, lo sappiamo che è veloce di tutto…