Argomento caldo di questi giorni è l’uscita della Pocket6k prima di IBC 2019, e la normale corsa al upgrade alla sorella della Pocket4k, perchè se ha 6k è sicuramente meglio della 4k, o forse no?

Argomento caldo di questi giorni è l’uscita della Pocket6k prima di IBC 2019, e la normale corsa al upgrade alla sorella della Pocket4k, perchè se ha 6k è sicuramente meglio della 4k, o forse no?

In un primo articolo ho detto per chi è meglio la pocket4k e in questo possiamo vedere per chi la Pocket6k può essere meglio. Non a caso Blackmagic ha scelto di fare due sorelle simili e diverse in alcune caratteristiche, sia per seguire il passo tecnologico a cui le altre case stavano approcciando, cioè il 6k, sia per prendere un altro mercato di filmaking interessante, sia per offrire ulteriori possibilità di scelta nella cattura dell’immagine.

1) Risoluzione

La Pocket4k è limitata (si fa per dire) al 4k DCI mentre la Pocket6k è una camera che offre molte opzioni di risoluzione partendo dal 6k raw, diversi fattori di ripresa anamorfica a scendere (in raw escluso il 4k, per motivi x, ma disponibile come prores). Ovviamente uno dei principali motivi per cui scegliamo la 6k è avere maggior risoluzione di lavoro su cui fare crop, scalare, ottimizzare angolazione etc

La Pocket4k è limitata (si fa per dire) al 4k DCI mentre la Pocket6k è una camera che offre molte opzioni di risoluzione partendo dal 6k raw, diversi fattori di ripresa anamorfica a scendere (in raw escluso il 4k, per motivi x, ma disponibile come prores). Ovviamente uno dei principali motivi per cui scegliamo la 6k è avere maggior risoluzione di lavoro su cui fare crop, scalare, ottimizzare angolazione etc

L’alta risoluzione unita alla bassa compressione dei dati pone la camera come ottima scelta per girare clean plate, materiale da cui trarre texture e fotogrammetria ad alta risoluzione.

2) Mount EF

Per alcune persone il mount EF è uno svantaggio, tiraggio più lungo quindi meno possibilità di usare lenti di mount diverso; dall’altra il Mount EF insieme al Mount Ai Nikon offrono uno dei parchi lenti più ampi della storia fotografica e video, quindi una camera con mount EF significa poter accedere a lenti con elettronica o manuali di alto livello. Inoltre grazie alla diffusione delle camere canon in ambito video, la disponibilità di tali lenti nel parco lenti personale dei filmaker è spesso molto ampia.

Per alcune persone il mount EF è uno svantaggio, tiraggio più lungo quindi meno possibilità di usare lenti di mount diverso; dall’altra il Mount EF insieme al Mount Ai Nikon offrono uno dei parchi lenti più ampi della storia fotografica e video, quindi una camera con mount EF significa poter accedere a lenti con elettronica o manuali di alto livello. Inoltre grazie alla diffusione delle camere canon in ambito video, la disponibilità di tali lenti nel parco lenti personale dei filmaker è spesso molto ampia.

3) Circuiti di Gain migliorati

La dimensione dei sensori è una lotta da sempre, da quanto è stato inventato il concetto di crop, dico inventato perchè è sempre esistito il principio, ma nessuno si faceva il problema, addirittura oggi leggo che le medio formato hanno il crop inverso… come se fossero le stesse lenti del formato 35 fotografico.

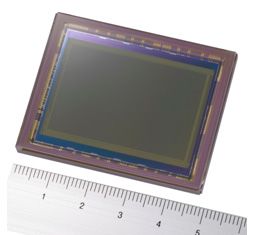

La Lumix GH5 ha un sensore m4/3 da 17.3 x 13 mm, la Pocket 4k ha un sensore Quattro Terzi da 18,96 mm x 10 mm, Aps-c Canon è 22.2 x 14.8 mm, la 6k monta un sensore Super 35 (23,10 mm x 12,99 mm), quindi leggermente più grande, il che offre un fattore di crop leggermente inferiore al primo.

Quello che importa in questo caso è il fattore di rapporto tra la dimensione del sensore e la risoluzione, per una questione fisica, se il sensore resta piccolo ma lo dividiamo in più fotorecettori, a parità di dimensione un sensore più risoluto necessita (teoricamente) più luce, quindi avendo una risoluzione superiore, i pochi mm di vantaggio fanno si che si possa ottenere senza grandi difficoltà una luminosità pari a quella raccolta in 4k dalla Pocket4k, la differenza tra le due camere di rapporto di luce guadagno viene allineato dai nuovi circuiti di guadagno.

4) Usarla per raffiche fotografiche Raw in alta risoluzione

La camera può essere usata in modo agile (come la Pocket4k) per girare sequenze raw e poi estrapolare i frame raw da usare come fotografie, con la differenza che la Pocket6k offre fotogrammi a 21megapixel di altissima qualità. In più di una occasione ho usato questa tecnica per catturare raffiche senza limiti di durata ad alta qualità.

La camera può essere usata in modo agile (come la Pocket4k) per girare sequenze raw e poi estrapolare i frame raw da usare come fotografie, con la differenza che la Pocket6k offre fotogrammi a 21megapixel di altissima qualità. In più di una occasione ho usato questa tecnica per catturare raffiche senza limiti di durata ad alta qualità.

5) Attualmente la 6k raw più economica sul mercato e già in vendita

Pur essendoci sul mercato diverse camere che registrano in 6k, a costi molti più alti, attualmente è la prima a fornire un 6k a bassa compressione (prores) o raw (Braw) è la Pocket6k, le alternative attualmente usano compressioni molto aggressive o permettono il salvataggio in raw solo con costosi moduli esterni.

6) Sulla Pocket6k si può avere uno Speedbooster interno

L’azienda Lucadapter, che produce una variante da inserire all’interno della UMP, sta pensando di produrre la stessa cosa per la pocket6k, ma per ora è ancora in fase di kickstarting, mentre per la pocket4k esistono sia i generici che quello dedicato da tempo, il vantaggio di avere un elemento interno evita giochi degli adattatori e meno possibili errori di allineamento delle lenti.

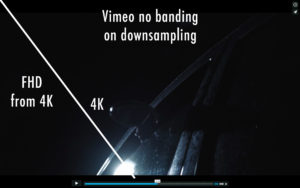

7) 4K reale oltre la matrice di Bayer

Il 4k ottenuto da un sensore 4k non è realmente un 4k a causa dei sensori con la matrice di Bayer, che nella fase di De-Bayering riduce la risoluzione effettiva, quindi il 6K è la soluzione ideale se si vuole ottenere il massimo della risoluzione reale.

Quest’ultima affermazione è stata aggiunta solo per completezza, ma sinceramente la trovo solo una fisima da pixel peeper.

Naturalmente la mia lista è relativa ad un discorso puramente generale, ognuno poi ha punti di vista diversi, personalmente la maggior parte di questi punti non mi tange, abituato a girare in dng non compressi o altri formati raw molto onerosi, ho usato la prima Alexa con il firmware 0.85 che registrava fullHd prores, senza audio, e ho avuto tante esperienze varie per cui … penso che queste due macchine siamo miracoli regalati alla massa.