Dopo aver chiacchierato con un po’ di persone ho pensato di buttar giù due riflessioni sulla sensibilità dei sensori moderni e sulla ignoranza che dilaga …

Dopo aver chiacchierato con un po’ di persone ho pensato di buttar giù due riflessioni sulla sensibilità dei sensori moderni e sulla ignoranza che dilaga …

Ormai se una camera non riprende al buio con 128.000 iso (ho scritto 3 zeri) sembra che sia inutilizzabile, infatti il cinema si è sempre fornito di pellicole a 128.000 iso… naturalmente…

quando ho detto di aver usato una cinepresa digitale che lavora a 400 iso mi hanno preso per folle, e hanno pensato che parlassi di un prodotto molto vecchio.

Il cinema è fatto di sensibilità e luce, luce che si riceve, che si cattura, che si riflette …

Quando il cinema incontra l’avventura Fitzcarraldo

Se girate documentari, posso capire la ricerca della luce naturale, ma non ricordo tra le pellicole approvate dal National Geographics sensibilità superiori ai 1600 asa, quando si parlava di fotografia, assolutamente 400 per quanto riguardava i documentari… il lavoro veniva rifiutato, perchè non era nei loro standard.

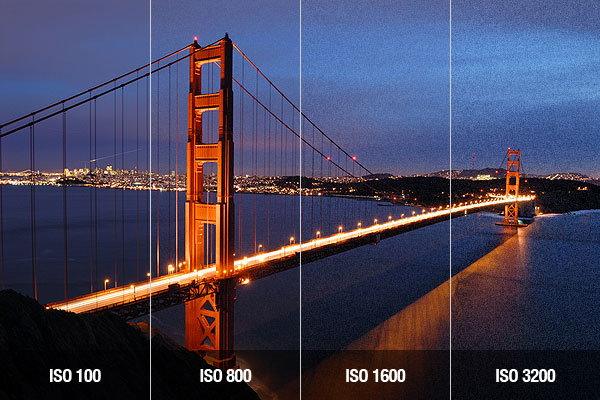

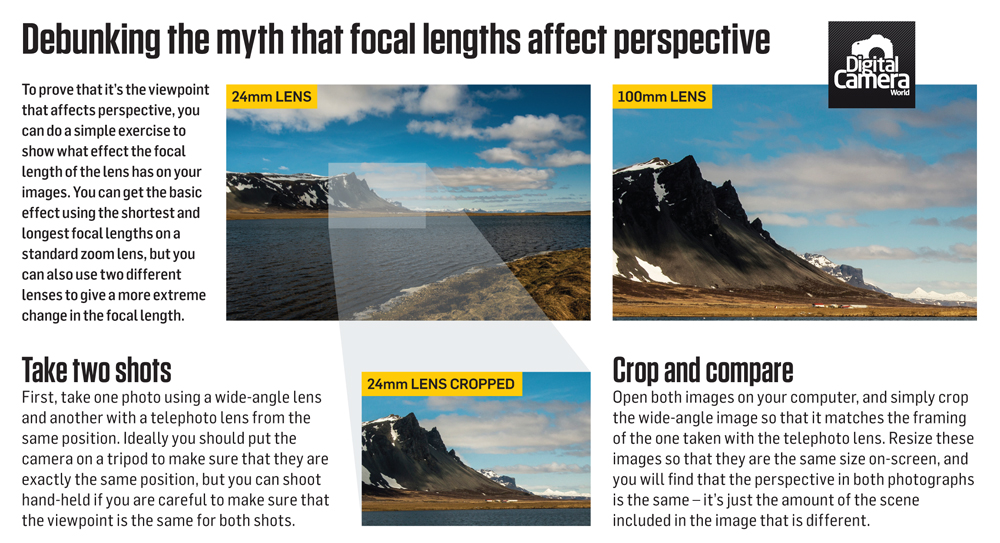

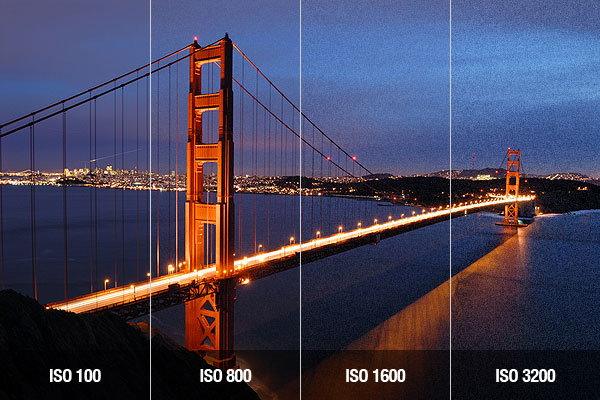

Kodak e Fuji hanno prodotto pellicola cinematografica fino all’anno scorso, ora solo per le copie d’archivio, e non hanno mai fatto pellicole troppo sensibili, perchè le emulsioni più sensibili erano meno nitide, sia per struttura dei grani della pellicola, sia per la lavorazioen durante lo sviluppo. Infatti regola aurea in fotografia è usa sensibilità bassa perchè corrisponde a granulosità fine quindi dettaglio e definizione.

I digitalartisti che sono nati col digitale, e non si sono sforzati di conoscere l’analogico almeno come base di teoria, sono convinti che tutto sia legato alla sensibilità del sensore e della macchina, dimenticando che poi un sensore troppo sensibile, o amplifica digitalmente il segnale, oppure diventa inutilizzabile di giorno, perchè si deve chiudere il diaframma così tanto (creando diffrazione e quindi perdita di nitidezza) o usando filtri ND così spessi da perdere nitidezza e/o causare dominanti a vignettatura laterale che non si potranno mai togliere in post se non con fatiche assurde.

Esempio, con sensore a 400 iso, alle 15 di pomeriggio devo chiudere in situazione media il diaframma a 8-11 per esporre correttamente, oppure usare un ND 16 per togliere gli stop necessari per poter gestire l’esposizione corretta.

Se devo fare delle riprese in orari più serali o notturni sarebbe innaturale vedere sempre e tutto, ma comunque usando ottiche prime più veloci (1.8-1.2) posso lavorare con immagini ottime e dettagliate.

Troppo spesso si spinge per avere native immagini che tra rumore, e distorsioni date dall’amplificazione del segnale diventano innaturali…

Una ottica 50 mm 1.4 a 1600 iso 1/48 fornisce una immagine paragonabile a quella dell’occhio umano medio, come contrasto, luminosità in esterni notturni.

Troppi pensano che il segreto del filmlike sia un uso di tecnologie molto spinte, mentre alle volte il vero segreto è lavorare entro i limiti delle macchine, e saperli gestire al meglio…

Ogni DoP serio sa che se la macchina offre 14 stop di gamma dinamica è meglio usarne 8-9 se va bene, perchè la testa e la coda… come per fare del buon whisky vanno buttate… è il motivo per cui è nato il Log, che oggi si usa più del Raw e con il raw; si prende il meglio della gamma dinamica, lo si rimappa nel range disponibile di registrazione comprimendo tutte le informazioni, ma potendole riespandere a posteriori oltre a recuperare tutta la gamma dinamica si ha una qualità che non si avrebbe mai lavorando con il video in modalità normale.

Un’altra leggenda / mistificazione che nasce ė che gli iso siano solo dei metadata, non è esatto, dipende da camera a camera.

Nella maggior parte delle camere ha un sensore con sensibilità fissa a xxx iso e si registrano queste informazioni nella registrazione del file raw, poi a seconda delle impostazioni della camera, se si è indicato un iso differente dall’iso nativo viene mostrata una immagine rielaborata in funzione delle informazioni dei metadata registrati nell’immagine. Per questo motivo salvare un file raw permette di manipolare l’immagine in postproduzione sfruttando tutte le informazioni originali.

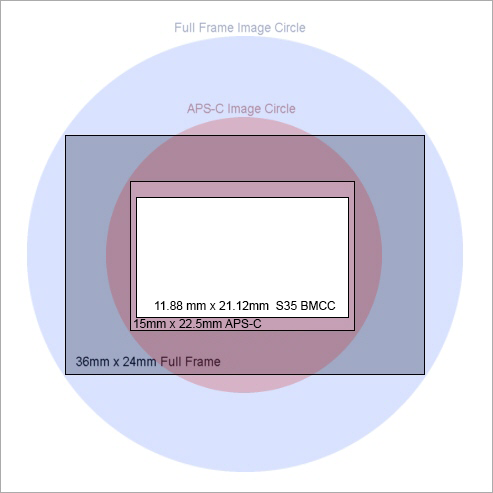

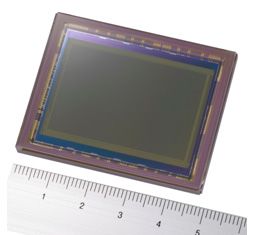

Questo però è valido solo se la registrazione del raw è fatta in modo completo, ovvero parliamo di camere di fascia alta come arriflex o red, mentre nel caso di BlackMagic Cinema Camera esistono si i metadata che indicano quale sia lo scostamento tra gli iso nativi e quelli artificiali, ma esiste una differenza fondamentale su come vengono registrati i dati.

L’iso nativo della bmcc è di 800 iso per la 2,5k e 400 iso per la 4k, mentre gli altri iso sono creati artificialmente facendo un sottocampionamento o un sovracampionamento delle informazioni. Teoricamente possiamo manipolare in post le informazioni, ma nel caso della Bmcc esiste un però…

La bmcc nasce con un ottimo sensore a 16bit, ma registra le informazioni in un file dng raw a 12bit Log, il che significa che dovrebbe registrare tutto il possibile, quando registra a iso nativi, ed è quello che bmd suggerisce per il maggior spazio di lavoro in postproduzione, quando invece lavorano in formato non nativo vengono applicate delle curve al log per prediligere le alte e le basse luci, quindi i 16bit rimappati sul 12bit log viene leggermente spinto nelle due direzioni, quindi in realtà potrebbe essere leggermente meno protetto come gamma tonale sugli estremi.

Ma quindi tutti questi iso in più servono o no?

Difficile dare un’unica risposta, diciamo che dipende da situazione e uso della camera :

PRO iso alti e bassi più ampi:

- registrando in prores si può avere più spazio di azione per la post perchè si registra una maggior quantità d’informazione nelle zone d’ombra che sarebbero più chiuse, o nelle alte luci

- avendo iso più alti si può vedere meglio per fare il fuoco

- avere iso più bassi può essere utile quando non si hanno filtri ND per ridurre la luce

CONTRO iso alti e bassi più ampi

- registrare a iso troppo alti può causare perdite di definizione e/o rumore eccessivo che rimane “inciso” nelle immagini

- registrare a iso bassi con il downsampling può clippare le alte luci a seconda dell’algoritmo che esegue il downsampling

- se si usano senza cognizione di causa si potrebbe limitare l’azione della post

Poi ci sono delle eccezioni, alcune camere sono dotate di un doppio ccd o cmos per la gestione di iso bassi e alti, in questo modo hanno praticamente due iso nativi (nuova panasonic varicam) e in quel caso questo discorso non vale.

Ma quindi queste camere BlackMagic Design poco sensibili?

Ma quindi queste camere BlackMagic Design poco sensibili?

dopo aver fatto un semplice esperimento, bmcc4K affiancata ad una canon 60D, scatti in raw su una e sull’altra, portati gli scatti dentro lightroom, gli scatti a iso nativi a 400 iso della bmcc4K sono stati schiariti in post per raggiungere i dettagli ottenuti con la 60D a 6400 iso raw, il risultato è praticamente lo stesso, solo più rumorose perchè la canon ha una riduzione rumore in camera nativa, ma una volta passata la riduzione rumore otteniamo lo stesso livello di informazione.

Naturalmente c’è un handicap per la bmcc perchè la blackmagic non ci ha mai pensato, che un iso più alto significa anche avere una immagine più luminosa per la messa a fuoco manuale.