Mission

In un mondo dove ormai sembra che il 4k sia lo standard anche sui cellulari, e se non si fanno riprese in 4k, si è degli sfigati, pensare di recuperare registrazioni in formato 353 x 288 è qualcosa di così arcaico che spesso non viene neanche consepito, eppure ognuno di noi ha personalmente o qualche parente che ha delle vecchie cassette vhs, vhs-c, video 8 da recuperare, dove ci sono ricordi, che anche se possono essere considerati poco nitidi per gli standard (teorici) attuali, sono importanti.

Il problema principale è come acquisire correttamente questo materiale, che a seconda dei vari metodi di lettura e cattura può essere ulteriormente deteriorato, oppure catturato in modo decente dai vari dispositivi. la differenza tra il procedere nel modo corretto o no comporta perdite di qualità notevoli, per cui se si tratta di uno o due nastri forse (sottilineo forse) è meglio consegnarli a dei professionisti per l’acquisizione con prodotti professionali. Naturalmente vanno verificati perchè molti sedicenti professionisti approfittando dell’ignoranza delle persone, spacciano per operazioni altamente professionali l’uso di lettori vhs di basso di livello e schede di cattura compresse o di bassa qualità, e conversioni colore dubbie.

Principi base

il formato VHS/8mm sono formati video degli anni 80/90 che avevano una risoluzione verticale nominale di circa 200 linee di definizione, quindi già di partenza non potevano catturare grandi quantità di informazioni, soprattutto perchè erano linee  interlacciate, quindi 100 per un campo, 100 per l’altro. Quindi nel momento in cui si parte sappiamo che già la cattura a 352 x 288 linee per un VHS è più che generosa perchè teoricamente, se va bene, se il nastro è in ottime condizioni, se il player vhs è in ottime condizioni con testine pulite, e un TBC per gestire e ottimizzare le sincronie di segnale possiamo ottenere una discreta immagine di partenza, in realtà le schede di cattura in quel formato sono scomparse e soprattutto la maggioranza comprimevano troppo i dati; la soluzione migliore è utilizzare una scheda in formato SD (720×576 in pal) per ottimizzare la qualità di cattura effettiva.

interlacciate, quindi 100 per un campo, 100 per l’altro. Quindi nel momento in cui si parte sappiamo che già la cattura a 352 x 288 linee per un VHS è più che generosa perchè teoricamente, se va bene, se il nastro è in ottime condizioni, se il player vhs è in ottime condizioni con testine pulite, e un TBC per gestire e ottimizzare le sincronie di segnale possiamo ottenere una discreta immagine di partenza, in realtà le schede di cattura in quel formato sono scomparse e soprattutto la maggioranza comprimevano troppo i dati; la soluzione migliore è utilizzare una scheda in formato SD (720×576 in pal) per ottimizzare la qualità di cattura effettiva.

All’epoca esistevano anche la versione “HD” di questi formati amatoriali che erano il S-VHS e Hi8 dove oltre a registrare circa 400  linee, separavano il segnale di croma dal segnale di Luma, quindi separando le due informazioni l’immagine era ulteriormente più pulita e nitida. Ma a causa di un prezzo notevolmente più alto, i dispositivi di registrazione, e la loro gestione era molto più costosa, per dare una idea, una camera VHS di discreta qualità NON PROFESSIONALE nel 1990 aveva un costo di quasi tre milioni di vecchie lire, che al cambio e considerando l’inflazione sarebbero quasi 6000 euro di oggi (considerando stipendio medio dell’epoca), cioè quanto una cinepresa digitale che gira in raw 4.6k oggi.

linee, separavano il segnale di croma dal segnale di Luma, quindi separando le due informazioni l’immagine era ulteriormente più pulita e nitida. Ma a causa di un prezzo notevolmente più alto, i dispositivi di registrazione, e la loro gestione era molto più costosa, per dare una idea, una camera VHS di discreta qualità NON PROFESSIONALE nel 1990 aveva un costo di quasi tre milioni di vecchie lire, che al cambio e considerando l’inflazione sarebbero quasi 6000 euro di oggi (considerando stipendio medio dell’epoca), cioè quanto una cinepresa digitale che gira in raw 4.6k oggi.

Il montaggio all’epoca era sempre una operazione a perdita, spesso notevole tramite la copia con cavi di non qualità eccelsa, ogni copia era una perdita di qualità notevole, per cui si cercava di generare meno copie possibili dall’originale in modo da ottenere un master da cui poi fare le copie di distribuzione.

Nel tempo i nastri possono essersi deteriorati, attaccati da muffe o da altri agenti, chimici e non, perchè parliamo di nastri a ossido di ferro e altre sostanze che nel tempo si alteravano, e per alcune persone (mio caso) generavano ottimi terreni di cultura di spore e muffe di diverso tipo. Purtroppo non era solo una questione di come erano conservati, ma anche dal tipo di produzione di tali nastri, all’epoca non si pensava ad un nastro low cost che sarebbe stato riletto dopo 20 anni.

Oggi da dove partiamo

La prima cosa che dobbiamo fare, se non lo possediamo già, è procurarci un buon strumento per leggere i nastri, procurarsi significa che dovremo cercare nel mondo dell’usato dei lettori VHS /Hi8 con TBC.

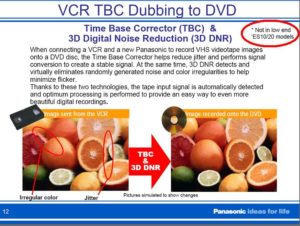

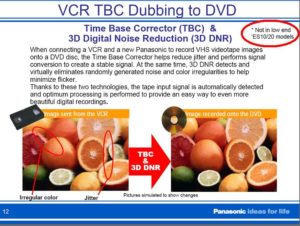

Il Time Base Corrector è un elemento di base per la lettura di qualità dei nastri che vogliamo riversare, senza di esso avremo problemi e potremmo perdere anche il 60% della qualità originale dei nastri, per oscillazione di segnale che causa neve, perdita di quadro, perdite di nitidezza e molto altro ancora.

Il Time Base Corrector è un elemento di base per la lettura di qualità dei nastri che vogliamo riversare, senza di esso avremo problemi e potremmo perdere anche il 60% della qualità originale dei nastri, per oscillazione di segnale che causa neve, perdita di quadro, perdite di nitidezza e molto altro ancora.

Nell’usato si trovano anche VHS semiprofessionale da banco, ma spesso la natura semiprofessionale significa anche che le testine sono state usurate da superlavoro, e oggi è improbabile trovare una ricambistica di questi prodotti, per cui possiamo avere più fortuna nei S-vhs casalinghi, di solito appannaggio degli appassionati, quindi ben tenuti, e di buona qualità.

Nella lettura dei nastri da telecamera la soluzione migliore sarebbe avere la telecamera originale, perchè nella registrazione magnetica c’era un ulteriore elemento di possibile interferenza, ovvero la regolazione dell’azimuth, la posizione del nastro rispetto alla testina di registrazione lettura, per cui semplici centesimi di mm di offset comportano errori, quindi nel momento in cui si legge il nastro da un altro dispositivo c’è la possibilità che non corrispondendo la regolazione, la resa dello stesso nastro vhs/hi8 sia pessima per colpa del sistema di lettura.

Il sistema di lettura del nastro è molto importante perchè se raccoglie correttamente il segnale, se la testina è correttamente allineata con il nastro (e non sempre si può gestire tale parametro) allora è possibile ricavare dal nastro il massimo delle immagini.

Schede di acquisizione

Anche se il formato VHS/8mm è un formato di bassa qualità utilizzare sistemi si acquisizione di bassa qualità castrano ulteriormente le capacità di cattura e conservazione di tali informazioni, per cui usiamo una scheda di cattura usb da 20 euro non possiamo aspettarci neanche la decenza nel materiale che andiamo a catturare. Se si ha un vecchio computer su cui montare le vecchie schede si possono trovare le schede pinnacle dv500 e simili che erano schede di alta qualità e valore per l’epoca (erano vendute a 2 milioni di vecchie lire) che oggi si trovano nell’usato tra le 80 e 100 euro perchè il tipo di slot delle schede è obsoleto e solo sui vecchi computer può funzionare. Altrimenti suggerisco una scheda Blackmagic intensity, che se limitata al FullHD (se per limitazione si può intendere visto che è 6 volte più definito di un S-vhs o un Hi8) la si trova nuova intorno ai 150 euro, usata intorno ai 100. Si parla di una scheda che ha ingresso analogico e digitale, e quindi può essere usata anche per altre soluzioni.

Acquistare una scheda di acquisizione significa computer, spazio su disco e altre operazioni intorno ad esso, ognuno può trovare comoda o no tale soluzione, può pensare che sia utile per altre operazioni o no, dipende cosa si vuol acquisire e la quantità di nastri da acquisire.

Soluzioni alternative

Spesso ci sono soluzioni diverse da quelle classiche, e/o più interessanti per gestire il materiale a nastro, e risolvere più di un problema in un colpo solo.

Telecamera HDV on IN-OUT : sul mercato alcuni anni fà uscirono delle camere HDV che avevano la possibilità di acquisire il materiale analogico in ingresso sull’entrata analogica, e registrarla su nastro o riversarla uscendo direttamente sul computer tramite la porta Firewire. A questo scopo utilizzo una camera Canon Legria HV30, che mi permette in un colpo solo :

- acquisire un segnale analogico da videoregistratori e convertito in digitale da un buon dac

- acquisire nastri Minidv Pal SD

- acquisire nastri HDV in formato HDV

il tutto senza schede di acquisizioni particolari, semplicemente una porta firewire 400, che se non presente sul computer costa non più di una quarantina di euro come scheda aggiuntiva. Nel mercato dell’usato questa serie di camere (hv20/30/40) si trovano intorno nei 200 euro in ottime condizioni.

DVD Recorder con Hard disk : oggi meno diffusi perchè la tv digitale terrestre prevede la registrazione semplificata dei flussi video con una semplice chiavetta, ma qualche anno fà ebbe un discreto successo la soluzione dei dvd recorder con hard disk che prevedevano la registrazione programmata dalla tv, la possibilità di editare semplicemente i filmati tagliando le parti non volute e la registrazione su dvd come dvd standard. La maggior parte di questi apparecchi avevano anche un ingresso Dv per registrare dalle camerine Dv e Hdv, i diversi ingressi audio video semplici, y/c e questo permetteva la cattura semplice di nastri vecchi su Dvd.

Anche questi prodotti permettono oggi la conversione da analogico a digitale senza passare per il computer, e una persona non ha interesse a manipolare il video, o fare particolari editing è una soluzione semplice da player a recorder in modo diretto, con poche operazioni da telecomando si possono togliere le parti di troppo e quindi ottenere dvd con i nostri filmati dei ricordi.

N.B. vi ricordo che i supporti DVD registrabili sono alquanto fragili e delicati, che possono perdere dati nel tempo, si graffiano, etc etc, quindi oltre a fare una copia su dvd personalmente eseguo una copia dell’immagine su HD di suddetti filmati, per evitare che non il deterioramento del nastro, ma il deterioramento del dvd cancelli i miei ricordi.

Glossario

Azimuth : regolazione della testina di lettura che indica la posizione della testina rispetto al nastro, la errata regolazione del tracking nastro testina comporta difetti ed errori delle informazioni. Molti videoregistratori hanno la regolazione del tracking automatica, e pochi quella manuale, sono preferibili i secondi perchè nel caso di nastri con registrazioni eseguite in tempi diversi e/o che non sono stati riavvolti da tempo è meglio poter fissare un tracking piuttosto che la oscillazione della regolazione automatica che può comportare più problemi che soluzioni.

RCA : connettore analogico attraverso il quale passa un segnale composito di colore e luminanza, spesso causa di possibili problemi di qualità se non ben realizzato, e/o ben schermato

S-VHS : versione avanzata del vhs con una maggior qualità e informazioni di linee fino a 400 linee con separazione di luminanza e crominanza.

Scart : il peggior sistema di trasmissione audio video, anche quando si separava la luminanza e la crominanza, il sistema combinato di cavi e connettori a lamella che spesso hanno falsi contatti, comporta un decadimento della qualità video / audio per le interferenze reciproche dei segnali da evitare SEMPRE.

TBC : il Time Base Corrector è uno strumento che serve a controllare e gestire le informazioni analogiche in arrivo dal nastro, leggere i segnali di sincronia, stabilizzarli, e ove ci sia qualche difetto qua e là tra i frame cercare di correggerli recuperando le informazioni tra un frame e l’altro, esiste anche nel VHS e 8mm ma nasce per esigenze più professionali.

VHS : formato più diffuso negli anni 80-90 di registrazione su nastro magnetico, il formato ha vissuto un lungo periodo di vita, con due derivazioni:

- S-VHS con il raddoppio delle linee di registrazione e lettura

- Compact una versione in dimensioni ridotte per la creazione di telecamere in formato ridotto

Y/C : connettore / sistema di trasmissione del segnale video in cui si separano luminanza e crominanza che offre una maggior qualità video rispetto agli altri sistemi di trasmissione del segnale S-VHS e Hi-8.

Spesso nella produzione di uno shooting fotografico la luce può cambiare, soprattutto in esterni con luce naturale, e si deve cercare di mantenere il più possibile allineati gli scatti tra di loro, anche se per scelta artistica si possono inserire scatti con colorimetrie differenti, mentre nel montaggio video la mancanza di coerenza delle immagini nei colori, nei contrasti, nella luminosità, o è una scelta estetica ben precisa collegata alla narrazione oppure diventa un elemento molto fastidioso e ogni stacco “non funziona” si sente che sono stati eseguiti in tempi diversi, con camere diverse, con luci diverse.

Spesso nella produzione di uno shooting fotografico la luce può cambiare, soprattutto in esterni con luce naturale, e si deve cercare di mantenere il più possibile allineati gli scatti tra di loro, anche se per scelta artistica si possono inserire scatti con colorimetrie differenti, mentre nel montaggio video la mancanza di coerenza delle immagini nei colori, nei contrasti, nella luminosità, o è una scelta estetica ben precisa collegata alla narrazione oppure diventa un elemento molto fastidioso e ogni stacco “non funziona” si sente che sono stati eseguiti in tempi diversi, con camere diverse, con luci diverse. Alcuni programmi, ad esempio Davinci Resolve, possiedono un sistema di analisi automatico delle diverse tabelle colore per poter leggere e aiutare la neutralizzazione dell’immagine tramite di essa, per cui se abbiamo una luce non neutra, alterazioni in qualche componente (ad esempio i led a bassa qualità cri che buttano verde dentro gli incarnati scuri) proverà a neutralizzare il tutto.

Alcuni programmi, ad esempio Davinci Resolve, possiedono un sistema di analisi automatico delle diverse tabelle colore per poter leggere e aiutare la neutralizzazione dell’immagine tramite di essa, per cui se abbiamo una luce non neutra, alterazioni in qualche componente (ad esempio i led a bassa qualità cri che buttano verde dentro gli incarnati scuri) proverà a neutralizzare il tutto.

E ci aggiungo quelli che senza usare uno strumento per misurare qualcosa (intensità, temperatura, tinta della luce, contrasto) cambiano temperatura, tinta, contrasto, luminosità del monitor per rendere più naturale e vicina l’immagine del monitor a quella che vedono, sottolineo l’immagine del monitor, non quello che riprende la camera… Questo procedimento genera due errori, perché la realtà ha un colore, la camera ne registra un altro, ma monitor ne vedremo uno simile a quello “reale”, peccato che ci serva a poco, anzi ci porti a credere che la camera registri quei colori, una deviazione della camera nel monitor di uscita e non nella camera….

E ci aggiungo quelli che senza usare uno strumento per misurare qualcosa (intensità, temperatura, tinta della luce, contrasto) cambiano temperatura, tinta, contrasto, luminosità del monitor per rendere più naturale e vicina l’immagine del monitor a quella che vedono, sottolineo l’immagine del monitor, non quello che riprende la camera… Questo procedimento genera due errori, perché la realtà ha un colore, la camera ne registra un altro, ma monitor ne vedremo uno simile a quello “reale”, peccato che ci serva a poco, anzi ci porti a credere che la camera registri quei colori, una deviazione della camera nel monitor di uscita e non nella camera….