Le camere Blackmagic dal 2012 stanno sconvolgendo il mercato, dopo la prima 2.5k con un sensore s16 l’azienda ha lanciato diverse altre camere per affrontare diverse fasce di prezzo, fasce di produzione, ambiti di lavoro.

Le camere Blackmagic dal 2012 stanno sconvolgendo il mercato, dopo la prima 2.5k con un sensore s16 l’azienda ha lanciato diverse altre camere per affrontare diverse fasce di prezzo, fasce di produzione, ambiti di lavoro.

Per una serie di combinazioni fortunate ho per le mani una BMP4K che mi sta dando tante soddisfazioni in tanti ambiti, da quello più complesso a quello più semplice della ripresa in stile camera ENG.

Su queste macchine sono nati tanti miti, sia perchè sono apparentemente “economiche ” (la 4k costa poco più di una 5d MKIII) e quindi accessibili anche ai newbey del cinema, sia perchè molte persone hanno avuto la pretesa da una Cinema camera come una telecamera amatoriale, ovvero tutta in automatico, avendo risultati poco entusiasmanti.

Essendo più economica di una controparte come Red o Arriflex tante persone hanno potuto acquistare la camera, ma senza la preparazione, o la voglia di imparare ad usare una Cinema camera, ovvero un prodotto che nasce per il cinema, con tutto ciò che ne consegue.

Il fatto ironico è che la maggior parte dei difetti che vengono imputati alla camera sono gli stessi che si possono trovare su camere professionali da una decina di volte il suo prezzo, ma in quel caso non si trovano tanti lamenti, ma al contrario si guarda l’estrema qualità che offrono queste macchine. Il problema vero è solo ignoranza sul prodotto, sul tipo di prodotto che gli utenti hanno per le mani, quindi si cercano funzioni o automatismi tipici dei prodotti amatoriali o semiprofessionali che non esistono sulle cineprese digitali.

Mito 1 : economica = non professionale

Molte persone sentendo il prezzo di base della camera la scambiano per una fotocamera e quindi la considerano più un giocattolo che una cinepresa. Partiamo dal fatto che la camera da sola non serve a nulla, quindi oltre alla camera si deve investire una cifra superiore a quella della camera stessa per renderla operativa aggiungendo ad essa come minimo le seguenti componenti :

- cage per gestire l’ergonomia della camera >150€

- supporto batteria v-lock o g-mount > 150€

- batteria g-lock v-mount 100 w > 200€

- microfono pro >200€

- recorder esterno / amplificatore audio > 300€

- ssd certificato 480gb (20 min raw -> 4 ore proresHQ) 250€

- zoom luminoso serio stabilizzato 2.8 minimo > 1200€

- Filtro ND variabile serio (per esposizione corretta) 200€

- Filtro IR per gestire IrPollution in situazioni complesse 180€

- cavalletto base ma stabile >750€

quindi l’investimento minimo è di circa 7000€ ben oltre la classica vDSLR o la telecamera media base, per cui proprio giocattolo non la definirei…

Se poi una persona vuole lavorare con più qualità, a questi elementi si devono aggiungere :

- Monitor serio SDI in Hd >500€

- Filtri ND a lastra pieni e sfumati

- Lenti prime 35mm-50mm-85mm-135mm >400€ per lente

Però chi arriva dal mondo Run&Gun delle VDSLR non si rende conto che si devono prendere un minimo di accessori ed elementi per rendere operativa la camera, nè accetta che se si vuol passare dalla serie C alla serie B si deve investire non solo soldi, ma anche tempo, studio, esperienza per usare al meglio il nuovo mezzo.

Mito 2 : la batteria dura poco e non si può cambiare

Molte persone che vengono dalle telecamere amatoriali o dalle fotocamere sono perplessi da questa scelta, che è comune nel mondo professionale, perchè la batteria interna non è una batteria da produzione, ma di sostegno, ovvero serve a mantenere operativa la camera quando si passa da una batteria esterna all’altra.

Le camere professionali usano sempre e solo batterie esterne, perchè montare una batteria interna di grande capacità appesantirebbe troppo la camera, e la renderebbe troppo ingombrante. Al contrario in caso di uso di Gimbal o strumenti in cui serve la camera più “free” la batteria interna consente in tante situazioni di agire dove una normale cinepresa sarebbe troppo ingombrante con una batteria aggiuntiva.

Mito 3 : ha pochi iso, non va bene per le situazioni LowLight

Le camere Blackmagic Design nascono con poche simulazioni di iso, solitamente 200-400-800 e alcune hanno anche il 1600 iso.

La scelta tecnica è evidente per una persona che ha sempre lavorato con la pellicola, mentre è incomprensibile per chi arriva dal video.

Un sensore, tranne che per alcune eccezioni, ha solo una sensibilità, mentre le altre sono solo elaborazioni digitali delle informazioni catturate dal sensore.

La BMPC4K è una camera che nasce a 400 iso, dove esprime il meglio della gamma dinamica, quando si lavora in low light

BMD ha fatto la scelta più efficace, catturare tutto il possibile dal sensore e poi decidere in post con calma quanto tirar su, come e quanto ridurre rumore, etc.

Per la simulazione dei diversi iso ho approfondito i vari principi di lavoro in un altro articolo.

Il vero problema di avere pochi iso disponibili nella scelta (che quasi nessuno in realtà vede, ma è reale) quando si riprende in lowlight, potendo solo arrivare a 800 iso come simulazione, diventa più difficile fare il fuoco manuale, anche con il focus peaking, mentre in camere dove abbiamo la simulazione di iso maggiori, è più semplice vedere per mettere a fuoco con poca luce, mentre con la BMPC4K o si ha un monitor esterno con lut e simili o diventa complicato, ma si fa, come si è sempre fatto con le cineprese in 100 anni di cinema, non a caso nel cinema a lato cinepresa c’è un misuratore di distanza digitale per i fuochi.

Mito 4 : produce file troppo grossi da usare

beh questo è il mito che mi fa più ridere… si compra una cinepresa digitale per avere qualità e poi si pretende che registri dei file compressi come l’h264 o h265… rovinando tutta la qualità che può offrire…

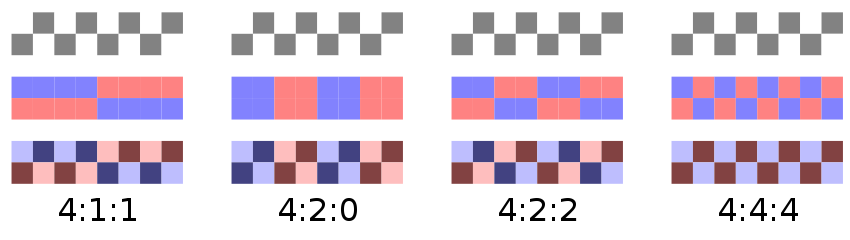

Comunque oltre al Raw, che effettivamente richiede spazio e potenza per lavorarlo la stessa camera può registrare in diversi formati prores molto più parchi nello spazio occupato pur mantenendo una qualità molto alta.

Dal 4k si può passare al formato fullHD che è di ottima qualità perchè è un downsampling del segnale 4k che arriva dal sensore, quindi con un dettaglio e una nitidezza incredibili occupando comunque uno spazio ragionevole.

Se si spende 7000 € per una camera e poi non si spende qualche centinaio di euro per gli hard disk del girato… cambiate mestiere…

Mito 5 : non scatta fotografie

Per forza è una cinepresa!!! se è per quello non va su internet, e non fa un buon espresso…

anche se la maggior parte delle telecamere scattano fotografie, spesso di qualità non eccelsa, non è molto assennato comprare una cinepresa per scattare fotografie…

E’ un commento fatto da chi arriva dalle vdslr, e mi lascia perplesso… a quel punto potrei rovesciare la domanda, se compri una fotocamera da 2500 euro perchè non fa bene i video in fullHD e 4K (A7 series esclusa) ?

Comunque se una persona volesse usare la BMPC4K come fotocamera, e si adattasse ad una ergonomia non adatta a questo scopo, basta mettere la camera in modalità raw, scatto in timelapse a 1minuto, e usare il bottone d’azione anteriore per lo scatto.

Di contro si può pensare alla BMPC4K come una delle poche fotocamere al mondo da 8.6 megapixel che può scattare raffiche di 30 fotogrammi al secondo per lo spazio disponibile sulla memoria, cosa che nessuna dslr può fare…

Personalmente ho una fotocamera per fotografare, una cinepresa per riprendere, ad ogni oggetto il suo scopo dove si esprime al meglio.

Mito 6 : ha un sensore piccolo per sfuocare

La BMPC4k ha un sensore s35 standard come Alexa e Red, quindi nel formato 35mm cinematografico, con le ottiche si comporta esattamente come si comporta una cinepresa di fascia alta; la ricerca dello sfuocato ad ogni costo è una moda moderna nata con le riprese fatte con le fullframe, dove la profondità di campo viene ridotta in modo esagerato e incontrollabile in una ripresa in movimento.

Non è un caso che il cinema sia stato per la maggior parte delle sue incarnazioni un formato 35mm, mentre il formato 70mm è sempre stato relegato a poche produzioni e in situazioni più particolari. Una dimensione di piano focale troppo grande costringe l’uso di diaframmi molto chiusi per poter gestire agilmente la profondità di campo sia nello statico ma soprattutto in movimento, ma chiudere troppo il diaframma può comportare il problema chiamato diffrazione che fa perdere nitidezza nell’immagine.

Col salire della risoluzione si deve andare di pari passo con la dimensione del sensore, ma se a livello pratico sensorre più grande uguale più luce, sensore più grande risoluzione più grande significa spesso incorrere nel problema della diffrazione.

Se volete approfondire il discorso dei formati della pellicola e dei sensori potete leggere questo articolo, mentre a riguardo dei vantaggi e svantaggi dell’uso di sensori di dimensioni grandi e piccole le trovate in questo altro articolo. Con l’esclusione di Barry Lindon dove Kubrick fece fare delle lenti apposite molto veloci, si tende a usare diaframmi più chiusi per non far impazzire i fuochisti e avere spazio di movimento.

Mito 7 : non ha un Nd integrato

Normalmente le telecamere hanno filtri ND integrati e non le cineprese, Blackmagic ha fatto una scelta ben precisa, ottimizzare i costi creando un corpo macchina cinema, con le logiche del cinema, nessun Dop serio userebbe un Nd interno se può scegliere un Nd esterno, magari sfumato e di qualità molto più alta.

Allora lo stesso tipo di difetto lo si può imputare a macchine più costose come Red o Alexa, ma nessuno sembra lamentarsene…

Mito 8 : non si possono cancellare le clip, riempirò il disco subito

vero, anzi verissimo, perchè come in altre camere professionali è impedita la cancellazione per due ragioni tecnico pratiche molto importanti :

- si evitano cancellazioni accidentali di clip da parte dell’operatore o altre persone attorno alla camera

- si evita la frammentazione del supporto con continue cancellazioni di clip e riscritture. Fondamentale quando si registrano dati raw a quasi 20 gb al minuto…

La frammentazione causerebbe sicuramente rallentamenti nella registrazione, e/o fotogrammi saltati durante la registrazione

Il problema di riempire i supporti è proprio relativo ai videomaker, o chi è nato col nastro (me compreso) perchè abituati a supporti molto economici si tende a sprecare registrando il superfluo, e quasi a caso nella speranza di azzeccare qualcosa di migliore nel riprendere di più.

Nel cinema non si possono registrare di nuovo le pellicole, si impressionano una volta sola, se si sbaglia, si butta la pellicola… Usare gli ssd con le Blackmagic Camera segue lo stesso principio, non si butta nulla, ma prima di fare una ripresa una persona deve pensarci bene e fare al meglio.

Più che un limite lo vedo come l’opportunità di lavorare al meglio per quello che si vuol fare, per imparare a inquadrare e riprendere meglio.

Mito 9 : è una camera rumorosa

Per fortuna.. come lo sono anche Alexa e Red quando non sono esposte correttamente, o una pellicola sottoesposta… La camera nasce IN TUTTO e per TUTTO una camera votata alla postproduzione, e la riduzione rumore è un processo da fare BENE in postproduzione, farla in registrazione è una necessità delle riprese Run&Gun, ma nel cinema si cattura il materiale al meglio e poi solo dopo si andrà a manipolare, campionare e rimuovere il rumore scegliendo per ogni inquadratura i settaggi migliori, senza perdere di definizione.

Inoltre è importante sapere che la camera è una macchina che deve lavorare in ETTR, ovvero una camera che si espone guardando l’istogramma e spostandolo dal centro un po’ a destra, in modo che si avrà l’immagine più pulita e definita possibile.

L’esposizione ETTR che molti fotografi già conoscono, sia moderni che utilizzatori della pellicola, spesso è poco compresa dagli utilizzatori classici di camere e telecamere.

Il concetto è molto semplice, per avere una immagine pulita senza rumore si deve offrire un minimo di xx informazioni luminose, quindi si apre il diaframma, si illumina, si gestisce l’esposizione per far si che le parti più buie abbiano più luce possibile senza mandare in saturazione le alte luci, poi in post si riportano le informazioni dell’istogramma nella posizione corretta, con la differenza che saranno più pulite.

https://youtu.be/NJQjGr1HNRY

Dato che sia il raw che il prores 10bit offrono maggior spazio di azione, registrare immagini un po’ sovraesposte (ma non clippate) offre la possibilità di catturare immagini più pulite, che verranno equilibrate a posteriori.

C’è un interessante articolo sull’ETTR sul blog di un filmaker molto in gamba Tom Majersky, per comprendere bene come funziona e come usarlo al meglio.

Mito 10 : non registra l’audio bene

La camera nasce con un micro microfono giusto di riferimento, poi ha due ingressi audio bilanciati per introdurre un segnale audio stereo di qualità. grazie ai ricenti firmware (dell’ultimo anno) è stata ottimizzata per registrare da microfoni esterni o attraverso recorder esterni un segnale audio di più che discreta qualità, visto che comunque cattura audio a 24bit 48 khz… Volendo si può collegare un microfono direttamente agli ingressi bilanciati, ma come per molte altre camere è meglio mettere in mezzo tra microfono e camera un amplificatore di segnale, o personalmente ho fatto la scelta di un recorder esterno Tascam dr-70, che fa sia da amplificatore che da recorder a 24bit 96khz, con canali separati (4) per cui ho sia una buona copia in camera dell’audio per il sinch automatico, sia un sistema di cattura e audio di alta qualità.

Potrei girare l’affermazione dicendo che tranne le vdslr panasonic le altre vdslr hanno un audio scarso e spesso non hanno neanche l’ingresso per l’audio serio da microfoni esterni…

Quali sono invece le informazioni che molti non sanno, e che invece sarebbe importante che i futuri acquirenti di una camera del genere dovrebbero sapere?

-

- la camera nasce con lcd posteriore a bassa risoluzione per una visione veloce e il controllo touch delle funzioni, avere un monitor esterno di qualità per fuoco e gestioni generali è fondamentale.

-

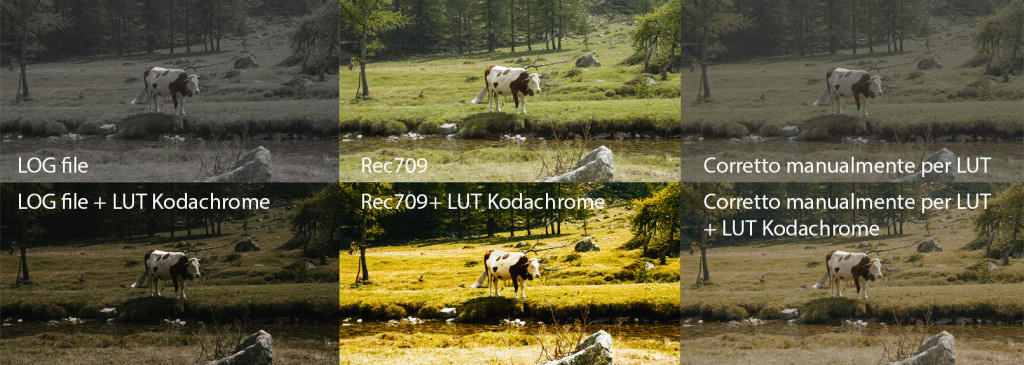

- la camera nasce per fare riprese votate alla post, se la si vuol usare Run&Gun esprime il suo meglio in FullHD proresLt dove tra scalatura e compressione il rumore è sparito nella maggior parte delle situazioni, e usando la curva Film si lascia ancora spazio alla post colore, mentre se si usa la curva Video, si ha già immagini di ottima qualità per montarle e usarle direttamente, essendo comunque dei file a 10bit.

-

- per registrare un audio buono è fondamentale introdurre un segnale di un microfono amplificato direttamente o con un amplificatore intermedio beachtek o simili, come si fa con le dslr, per avere un buon rapporto segnale rumore

-

- non tutte le ottiche canon compatibili sono supportate completamente, in particolare quelle che non hanno acquisito da canon gli schemi di costruzione delle ottiche e dell’elettronica, ma hanno fatto reverse engeneering (non faccio nomi, ma nell’ambiente e con una ricerca google si scopre), in quei casi la stabilizzazione potrebbe non essere supportata, come anche il fuoco automatico o il controllo diaframmi. Con l’uso delle ottiche native canon in generale si ha compatibilità quasi totale.

-

- nascendo come cinema camera, anche riggata, è comunque una camera massiccia e che per le riprese in movimento richiede un certo tipo di attrezzatura per essere “mossa” in libertà.

-

- il meglio dello sviluppo dei file avviene con DaVinci Resolve, che viene fornito in licenza full con la macchina, in particolare i file raw, ciò che si può estrarre dai file raw con davinci, per quanto si usino altri software evoluti, non si estrae tutta la gamma tonale, e comunque non con la stessa semplicità e pochi click.

-

- come indicato nel mito 9, si deve sapere come va esposta, ovvero dato che il sensore lavora come la pellicola, si deve saper gestire al meglio il tutto, per poter estrapolare il massimo della qualità, se l’esposizione viene gestita in modo normale il sensore non riceverà il massimo della luce che serve e quindi i risultati saranno sempre di qualità più scarsa. Questa camera preferisce lavorare in ETTR, se non si applica questo sistema di esposizione le immagini saranno oltre che più piatte, più rumorose di quello che serve, inutilmente, meno dettagliate e povere d’informazioni nelle ombre.

- la camera, come Alexa e Red soffre di IR pollution, quindi usando i filtri ND per ridurre la luce di giorno (perchè il problema non è quando manca luce, ma quando ce n’è troppa) si deve usare un filtro ircut che tagli le frequenze da 680 nm per evitare che i filtri neutri più forti diano una una dominante rosso marcino alle immagini.