Esposizione corretta

Spesso quando si parla di corretta esposizione sembra che si parli di magia, di pareri, opinioni … mentre sono semplici dati tecnici da leggere e applicare in ripresa e poi eventualmente in post.

Ogni mezzo (sensore o pellicola) ha una sua sensibilità nativa (Iso o Asa a seconda della scala), la giusta esposizione è quando si studia e si espone per il corretto valore del media, al di sotto facilmente si ottiene grana / rumore, al di sopra si tende a appiattire e poi bruciare le informazioni. La tolleranza alle oscillazioni di valore dipende dalla tipologia di pellicola o dalla tipologia di sensore, motivo per cui non basta usare un esposimetro per esporre una camera analogica o digitale, ma si devono fare prove e farsi esperienza per estrapolare il meglio dal sensore o dall’emulsione.

Decidere invece come usare l’esposizione e le luci invece è una questione estetica, artistica e si declina nel gusto, nelle necessità della scena, della fotografia, dell’ambiente e del sistema di cattura della luce che stiamo usando.

Per controllare l’esposizione dell’immagine abbiamo più elementi da tener conto, qui vediamo i diversi valori che ci permettono di avere un controllo totale dell’esposizione dell’immagine.

Il diaframma

Il primo valore che determina la quantità di luce catturata e registrata dalla macchina è l’obiettivo stesso, la capacità dell’obiettivo di aprire e chiudere il diaframma. Il valore del diaframma viene espresso in numeri, quelli più bassi indicano il diaframma più aperto, mentre quello più alto è la chiusura massima che si può ottenere.

Il diaframma della lente aprendosi e chiudendosi ci permette di decidere quanta luce possiamo portare al sensore; quando il diaframma si chiude può avere valori molto alti come 16 o addirittura alcuni obiettivi hanno valore 32, mentre quando si apre possiamo avere lenti che hanno un valore 1.4 o 1.2.

Quando apro e chiudo il diaframma non influenzo solo la luce in ingresso, ma anche la profondità di campo, ovvero la capacità di avere una zona più o meno ampia nitida, quindi quando voglio dare maggiore importanza al soggetto in primo piano posso aprire diaframma per sfocare maggiormente l’immagine dietro di esso. Naturalmente devo compensare la maggiore o minor luce in ingresso.

In sintesi :

il diaframma più è alto il numero, più è chiuso, più profondità di campo; più è basso e più è ristretta la profondità di campo.

Quando si devono scegliere i diaframmi da usare, si tende a non usare i diaframmi estremi, anzi si tende ad escludere il diaframma più basso, perché potrebbe non esprimere il massimo della nitidezza; si tende ad escludere gli ultimi due diaframmi più chiusi, perché a seconda delle lenti si rischia la diffrazione, fenomeno che causa una perdita di nitidezza.

Iso o Asa

Un altro elemento da tenere in considerazione quando andiamo a gestire la luce è la sensibilità ISO o ASA, a seconda delle macchine potremmo trovare una delle due sigle che indicano la sensibilità del sensore alla luce, ovvero la sua capacità di catturare la luce.

Una volta con la pellicola la sensibilità era gestita in modo diretto, ovvero si caricava una pellicola a 80, 160, 320, 640, quindi si esponeva di conseguenza.

Nel momento in cui si è passati al digitale apparentemente le macchine sono in grado di cambiare quello che sono gli Iso/Asa, ovvero sono in grado di abbassare o alzare questo valore per semplificare la fase di ripresa. Dico apparentemente perché in realtà questo tipo di valore anche col digitale è fisso, tranne un paio di camere di alta gamma Varicam della Panasonic.

Nel mondo reale abbiamo un valore che è quello detto sensibilità nativa, la capacità nativa del sensore di catturare quella data quantità di luce, poi quello che sono le sensibilità inferiori o superiori sono elaborazioni o a livello analogico del segnale elettrico catturato da sensore o a livello digitale sulle successive informazioni convertite in digitale.

Tradotto in parole povere significa che ogni macchina che noi andiamo a prendere telecamera e macchina fotografica cinepresa ha una sua sensibilità nativa, quando non utilizziamo la sua sensibilità nativa, apparentemente vedremo immagini più chiare e più scure ma in realtà dato che vengono create queste informazioni per elaborazione analogico – digitale la qualità non sarà come avere un sensore più sensibile o meno sensibile ma sono sempre elaborazioni del segnale originale.

Conoscere la sensibilità nativa di una camera è molto importante perché è la sensibilità nel quale la telecamera, la macchina fotografica, la cinepresa esprimono la loro capacità massima di catturare l’immagine, nella sua luminosità, nella capacità di leggere il contrasto massimo tra luce e ombra.

Quando noi abbiamo una macchina ad esempio prendiamo una macchina fotografica che nasce a 160 ISO e impostiamo un valore di Iso superiore ad esempio mettiamo 1600 o 3200iso perché c’è veramente poca luce nell’ambiente, potremo notare come aumenti una sorta di rumore video, un disturbo, una granulosità che appare sull’immagine perché l’immagine originale viene amplificata quindi fisicamente non è sensore che legge 3200 iso, ma è una elaborazione digitale o analogica.

Molte macchine (telecamere e macchine fotografiche) hanno un sistema di riduzione rumore direttamente in camera, altre (cineprese) per evitare di danneggiare l’immagine o perdere dei dettagli importanti riservano questa fase di riduzione del rumore alla fase della post produzione.

Quindi a seconda della macchina che utilizziamo, possiamo avere una sensibilità iso/asa nativa e un certo range, una gamma di sensibilità aggiuntive che possiamo selezionare per catturare più o meno luce in funzione della luce ambiente e della qualità che mi può esprimere.

Quanti e quali iso/asa possiamo usare di una camera è un qualcosa che dobbiamo verificare, perché ogni macchina offre intervalli di sensibilità più o meno usabili a seconda della quantità di luce che noi abbiamo nell’ambiente di ripresa. Quindi non è possibile dare un’indicazione generica di una sensibilità Iso da utilizzare, ma bisogna scoprire qual è la sensibilità nativa e poi vedere quanto ci possiamo spingere oltre; se parliamo di telecamere normalmente è abbastanza facile perché noi troveremo la macchina con la sua sensibilità di base e poi troveremo un parametro normalmente chiamato Gain o guadagno; il guadagno è quanto stiamo amplificando il segnale elettronicamente, senza guadagno è la sensibilità nativa della macchina.

Con le macchine fotografiche la sensibilità nativa è il valore Iso più basso della macchina, quindi molte macchine hanno ad esempio 160 ISO o 200 Iso; tutte le sensibilità Iso superiori sono elaborazioni, sta poi a noi verificare quali sono usabili quali diventano eccessivamente artefatte per essere utilizzate.

Sulle cineprese nella parte del manuale delle istruzioni è indicato qual è il valore nativo della sensibilità Iso e quali sono gli altri valori che noi possiamo utilizzare come sensibilità pari di xxx.

Quando noi cambiamo la sensibilità Iso e abbassiamo il valore rispetto al valore nativo il risultato è che la sensibilità si abbassa perché la macchina campiona meno informazioni luminose e non abbiamo particolari problematiche, quando noi alziamo la sensibilità Iso, dato che stiamo amplificando un segnale con poche informazioni, poca luce, il possibile deperimento dell’immagine è evidenziato da l’aumento di granulosità o elementi di disturbo video in movimento, l’aumento del contrasto dell’immagine.

L’aumento di contrasto diventa più evidente quanto meno luce è presente; perché se ci sono poche informazioni luminose per rendere più luminosa l’immagine l’aumento degli Iso sposta nelle due direzioni la parte più luminosa e la parte più scura aumentando il contrasto generale dell’immagine.

È molto importante quando si lavora con una camera capire qual è il livello di Iso utilizzabile, entro quale livello possiamo alzare la sensibilità senza avere un deterioramento troppo vistoso dell’immagine.

Per poter gestire l’immagine anche in condizioni di basse luci la soluzione ottimale di gestione dell’Iso è quella di utilizzare iso nativo, e gestire la luce con uno degli altri parametri, ma naturalmente non sempre è possibile farlo e quindi il parametro Iso è uno strumento utile per gestire la quantità di luce che viene catturata per ottenere la corretta esposizione.

Otturazione

Quando eseguiamo una ripresa l’altro fattore che influenza l’esposizione si chiama tempo di otturazione, detto anche shutter molte macchine.

Il tempo di otturazione è l’istante, la frazione di tempo che viene utilizzata per catturare il singolo fotogramma, quindi con un tempo di otturazione più alto o più basso catturiamo più o meno luce. In fotografia si utilizza il tempo di otturazione per modificare anche la quantità di luce che entra all’interno una camera, quando si cattura un filmato il tempo di otturazione non va mai utilizzato per controllare la quantità di luce in ingresso, perché nel momento in cui alteriamo il tempo di otturazione stiamo alterando l’immagine viene catturata da sensore, non è solo una questione di luce, ma è anche una questione di percezione del movimento.

L’impostazione corretta del tempo di otturazione è sempre un valore ben preciso, legato ai fotogrammi al secondo, esistono solo due eccezioni in casi speciali che andremo a elencare più avanti.

Il valore di otturazione corretto per ottenere la cattura di un movimento in maniera fluida è uguale a uno fratto il valore doppio dei fotogrammi al secondo, significa che se io lavoro a 24 fotogrammi al secondo per il cinema, utilizzerò 1/48 di otturazione standard, se io lavoro per la televisione per il video in ambito europeo o australiano dove abbiamo il sistema standard denominato PAL siamo a 25 fotogrammi al secondo, quindi utilizzo una otturazione di 1/50 di secondo, se lavoro per Stati Uniti e Giappone quindi lo standard NTSC, oppure se devo visualizzare il filmato prettamente su computer, tablet e cellulari allora utilizzo di 30 fotogrammi al secondo, quindi il tempo di otturazione sarà 1/60.

Questa semplice formula nacque al tempo del cinema quasi 100 anni fa, la particolare proporzione tra la velocità di otturazione e la cattura di fotogrammi ci offre la corretta scia di movimento sugli oggetti veloci, per far sì che quando noi vediamo filmato lo percepiamo come un movimento continuo.

Utilizzare una velocità / tempo di otturazione differente significa alterare la percezione del movimento catturato, se io voglio ottenere un movimento più mosso allora utilizzo un valore più basso di otturazione ad esempio se io utilizzo valore di otturazione di 1/25 invece di 1/50 l’immagine in movimento sarà più mossa, quindi diventerà più faticoso leggere i dettagli, perché i movimenti si fondono tra di loro, questo tipo d’impostazione si può utilizzare se dobbiamo fare una panoramica a schiaffi molto veloce e non vogliamo vedere gli elementi ma vogliamo vedere una fusione totale di ciò che noi riprendiamo nella panoramica a schiaffo; possiamo utilizzare il trucco di abbassare il tempo di otturazione quando abbiamo veramente poca luce, una camera statica, non abbiamo movimenti veloci nella scena; con una otturazione di durata doppia abbiamo la possibilità di catturare il doppio della luce a parità di scena e diaframmi e iso.

Utilizzare un tempo di otturazione più alto del normale rende invece movimento stroboscopico, quando il tempo di otturazione è più alto del normale oltre a catturare meno luce congela il movimento in ogni istante, in maniera più netta, quindi se ci sono dei movimenti veloci diventano stroboscopici perché i vari fotogrammi non si fondono uno con l’altro per il cervello, ma il cervello percepisce in modo diverso e più fastidioso l’immagine, quel tipo di impostazione si utilizza esclusivamente se in produzione si vuole una ripresa al rallentatore e quindi sia bisogno di immagini nitide e molto dettagliate sintesi l’otturatore va impostato sempre a uno fratto il doppio dei fotogrammi al secondo.

Le uniche eccezioni su questo tipo di situazione sono legate alla creazione di effetti speciali, rallenty, oppure per necessità di catturare più luce possibile nella scena, altrimenti il movimento catturato sarà pieno di artefatti nel movimento cioè non sarà naturale

In sintesi

Otturazione sempre 1/fotogrammi al secondo x 2

Manipolazione esterna alla camera della luminosità

Quindi se vogliamo riassumere i parametri, noi sappiamo che iso dovrà essere impostato preferibilmente nel valore nativo e non dovremmo cambiarlo, il tempo di otturazione andrebbe impostato sempre uno fratto fotogrammi al secondo per due, quindi se dobbiamo controllare la luce da quello che abbiamo detto fino ad ora l’unico parametro che possiamo cambiare è il diaframma, ma abbiamo visto che comporta una variazione non solo della luce in ingresso ma anche della profondità di campo.

Quando noi vogliamo impostare determinati valori diaframma / otturazione / iso, per controllare correttamente l’esposizione dobbiamo quindi agire esternamente alla nostra camera, quindi se abbiamo poca luce dovremo in qualche modo aumentare la quantità di luce disponibile nella scena tramite pannelli riflettenti, tramite luci aggiuntive, eccetera o se invece la luce è troppa possiamo utilizzare pannelli riflettenti neri o bandiere per ridurre la quantità di luce che raggiunge i soggetti, oppure possiamo utilizzare davanti alla lente della camera quello che si chiama un filtro neutro, il filtro neutro è un filtro più o meno scuro che riduce la quantità di luce che colpisce la lente dell’obiettivo.

Riducendo la quantità di luce col filtro ND (neutro) possiamo controllare la esposizione dell’immagine. In questo modo noi siamo in grado di controllare completamente la quantità di luce in ingresso nell’immagine senza toccare i parametri che influenzano gli altri tre parametri : otturazione iso e diaframma.

I filtri neutri esistono in tre incarnazioni ovvero ci sono i filtri neutri digitali introdotti da Sony, che elaborano l’immagine per permetterci di lavorare più comodamente senza dover introdurre elementi davanti alla lente della camera davanti alla lente della camera.

I filtri neutri variabili ovvero un filtro che noi avvitiamo sulla lente della camera e girando in senso orario o antiorario possiamo far passare più o meno luce.

Il filtro neutro variabile è uno strumento molto comodo molto flessibile perché ci permette di controllare in maniera raffinata e precisa la quantità di luce che passa; esso ha due possibili inconvenienti :

- il primo inconveniente è relativo alla qualità del filtro, se non è un filtro di alta qualità potrebbe influenzare la luminosità e soprattutto la nitidezza dell’immagine stessa quindi è molto importante investire una buona cifra sul filtro neutro per poter avere un’ottima qualità di resa ottica;

- il secondo fattore che potrebbe (uso sempre il condizionale perché dipende dalla situazione situazione) influenzare la qualità dell’immagine è legato alla natura stessa del filtro neutro variabile, esso è formato da una coppia di polarizzatore che incrociandosi riducono la quantità di luce che passa.

Dato che si parla di filtri polarizzatori, c’è il rischio che qualche tipo di riflesso che io voglia disegnare su una superficie, su un attore vada sparire perché viene polarizzato dal filtro neutro stesso, questo tipo di problematica relativa dipende da situazione a situazione, esiste una semplice soluzione ovvero montare un filtro variabile su un’altra ghiera, che ci permette di girare dopo aver deciso la quantità di luce in entrata, quindi orientare il polarizzatore per quello che ci serve.

Il terzo tipo sono i filtri a lastra ovvero la modalità di sottrazione della luce è unica perchè abbiamo un oggetto che in modo lineare filtra una parte della luce.

Il filtro a lastra normalmente è di qualità superiore ai due precedenti tipi di filtri, ma ha lo svantaggio che a seconda di quanta luce c’è dobbiamo sostituire un filtro rispetto all’altro, richiede un investimento maggiore rispetto al filtro variabile e digitale, richiede avere un porta filtri dove mettere il filtro, ed essendo un elemento che rimane distante rispetto al classico filtro della lente c’è il rischio che possa raccogliere qualche riflesso di luce

La soluzione ottimale è il filtro lastra a livello di qualità di immagine, a livello di praticità il filtro variabile è molto più comodo ed efficiente, quindi a seconda del tipo di lavoro che uno fa, in funzione dei tempi e dei budget a propria disposizione. Il meglio sarebbe poter possedere entrambi, in caso di scelta pratica economica il filtro variabile di qualità dovrebbe essere sempre la prima scelta per una questione di convenienza unita alla praticità di poter avere diverse scale diaframmi che possiamo sottrarre immagine

Esposizione ETTR questa misteriosa…

da qualche tempo si parla di esposizione ETTR in elettronica, ma spesso non è chiaro il perchè di tale scelta, perchè guardando le immagini sembra esserci un errore di esposizione.

L’esposizione detta ETTR Expose To The Right è un metodo di esposizione che tende a sovraesporre in modo più o meno significativo le immagini per ottenere in postproduzione una maggior pulizia delle ombre e/o minor rumore generale.

Questo metodo deriva dal principio dell’esposizione in pellicola, dove una maggior quantità di luce rende il negativo più denso e quindi con un numero maggiore di informazioni rispetto ad un negativo sottoesposto che riceve meno informazioni.

Nell’ambito del digitale dipende da sensore a sensore e come viene usato, perchè ogni sensore ha una sua gamma dinamica di lettura, ma non significa che la si possa sempre salvare, ad esempio le video reflex hanno una gamma dinamica più estesa rispetto alle classiche telecamere, se fanno fotografie, ma quando registrano il video comprimono questa gamma dinamica in uno spazio molto più ridotto : 8 bit contro i 14 bit della cattura fotografica, quindi anche se le informazioni di partenza hanno una certa qualità, queste informazioni vengono compresse in uno spazio più ridotto.

Il nome è nato dal tipo di istogramma che si può leggere dalle immagini ETTR, dove l’esposizione sposta l’istogramma dalle informazioni dei medi alle alte luci.

Il concetto nasce da più motivazioni :

- immagini più chiare vuol dire ombre più ricche di dettagli, e si può a posteriori abbassare l’esposizione ma avere dettagli anche nelle ombre.

- immagini più chiare vuol dire compressioni migliori, perchè i codec di compressione a perdita riducono e comprimono molto di più le aree scure delle chiare

- immagini più luminose normalmente vuol dire avere più informazioni nei medi e nelle alte luci, quindi immagini che percettivamente sono molto più interessanti.

- ombre più chiare vuol dire meno rumore nelle stesse e quindi immagini più pulite

Quanto e quando si usa l’ettr dipende da diversi fattori, non è una tecnica lineare, ma si può applicare SOLO facendo esperimenti con le proprie attrezzature e si deve capire quale sia il limite delle stesse.

- Ogni sensore ha il suo limite in alto e in basso come sensibilità, si tratta di testare quali sono i limiti, normalmente le macchine che registrano a 10bit il video, o meglio ancora in raw reggono molto di più delle camere tradizionali l’applicazione dell’ettr, perchè hanno più spazio di azione per recuperare le alte luci.

Per capire i limiti si deve esaminare e scoprire come l’istogramma della camera (o dal monitor di controllo) vi fornisce i dati su luci e ombre.

Alcune camere forniscono l’istogramma in relazione al sensore, altre alla capacità di registrazione. E’ importante verificare come funziona tale strumento per evitare di bruciare le immagini.

Ad esempio le camere Blackmagic Design forniscono un istogramma e la zebra in relazione al sensore, quindi SOLO al salvataggio in raw, mentre se si lavora in prores si deve essere più conservativi, impostando la zebra al 95%, altrimenti le aree si bruciano.

- Ogni sistema di registrazione interno o esterno può fornire una maggior capacità di registrazione delle informazioni lette dal sensore, dipende da come la camera gestirà la cosa, per cui va verificato, ad esempio nelle videoreflex poche hanno uscite video di qualità, oltre 8 bit 4:2:0, per cui un recorder esterno di qualità potrebbe essere uno spreco di soldi, dipende dall’uso che ne farete.

- Ogni lente può reggere in modo diverso alla sovra esposizione, ad esempio la maggior parte delle lenti presenta un “purple fringing” ovvero un’area viola attorno alle parti sovraesposte, per cui si può recuperare le aree sovraesposte, ma rimangono aloni colorati che non si possono recuperare facilmente, a livello fotografico dentro Adobe Camera Raw c’è una funzione apposita, ma nei filmati non è così scontato.

- A seconda dello spazio colore usato rec709 o log si hanno spazi diversi di recupero delle informazioni luminose, e considerato che molte macchine hanno metodi diversi di registrazione del log, se l’immagine non ha un grande contrasto il rischio di usare la tecnica dell’ettr in modo spinto comporta un appiattimento troppo forte delle immagini per poi ricostruire le informazioni che servono per generare l’immagine finale, ad esempio in log dove spesso l’esposizione delle alte luci si attesta intorno 80 usare l’ettr porta spesso il rischio di bruciare le alte luci

- seguendo la logica dell’ETTR si ha meno consistenza tra uno shot e l’altro perchè si tende a esporre al max ogni ripresa, quindi gli elementi fondamentali come l’incarnato potrebbero variare troppo durante gli stacchi, per cui è importante utilizzare i Falsi colori durante l’esposizione in ETTR per mantenere la consistenza di esposizione tra una inquadratura e l’altra degli elementi fondamentali dell’inquadratura, meglio ancora se si tiene costante l’incarnato di un attore di riferimento, altrimenti la fase di postproduzione può diventare lunga e scomoda.

Come gestirlo in ripresa

Dato che la maggior parte dei monitor interni ed esterni delle camere sono limitati sia come gamma dinamica che capacità di riproduzione del colore e della luminosità, va evitato il loro uso per gestire l’esposizione in ETTR, vanno usati gli strumenti per leggere e capire la vera luminosità delle diverse aree.

Istogramma

Zebra

Falsi colori come funzionano e come leggerli.

Questi strumenti, usati correttamente aiutano a capire quanto possiamo andare a destra con i dati, naturalmente dipende sempre dalla capacità di cattura del sensore e dai vari fattori di gestione della luce. Non va usato sempre e comunque, soprattutto a seconda delle situazioni e del contrasto globale dell’immagine.

Nota Tecnica :

ho preferito lasciare la spiegazione più tecnica alla fine, perchè non a tutti interessano le spiegazioni tecniche dietro alla pratica.

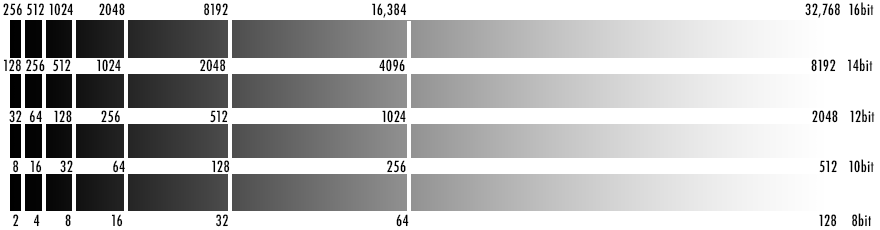

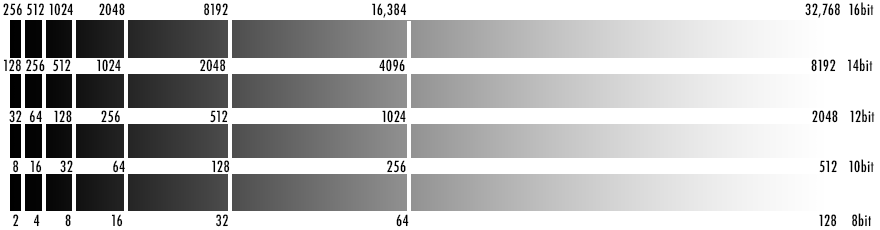

I sensori moderni tendono a lavorare con un principio di esposizione legato a come funziona la sensibilità “digitale” alla luce : quando il sensore quando riceve la luce la differenza di un valore intero di stop (tempo/diaframma) si traduce nel raddoppiare o dimezzare la luce catturata; le tonalità di un’immagine rappresentano la quantità di luce registrata, quindi lo schema di gestione delle informazioni è strutturato allo stesso modo. Immaginiamo un sensore in grado di catturare 16.384 tonalità differenti (14 bit RAW), la metà di queste informazioni 8.192 saranno devolute allo stop più luminoso (l’area a destra dell’istogramma), poi gli stop inferiori avranno rispetticamente ognuno la metà delle informazioni del precedente, quindi rapidamente scendendo verso le ombre le informazioni caleranno in modo drastico.

Guardando questo schema si può notare come già usando una registrazione raw a 14 bit (altissima qualità) il numero maggiore di informazioni viene registrato nella parte alta delle luci, ma se si lavora con la classica registrazione dei sensori a 8 bit diventa FONDAMENTALE tenerci alti con l’esposizione perchè fisicamente il numero di dettagli registrabili cade velocemente, per cui anche avendo tante informazioni nelle ombre, la distribuzione delle informazioni è fondamentale per registrare più informazioni possibili e spostarli nella parte alta è fondamentale, ragione per cui si usa lo spazio log di registrazione che spostando verso il centro le informazioni si cerca di conservare più informazioni possibili dai sensori.

Guardando questo schema si può notare come già usando una registrazione raw a 14 bit (altissima qualità) il numero maggiore di informazioni viene registrato nella parte alta delle luci, ma se si lavora con la classica registrazione dei sensori a 8 bit diventa FONDAMENTALE tenerci alti con l’esposizione perchè fisicamente il numero di dettagli registrabili cade velocemente, per cui anche avendo tante informazioni nelle ombre, la distribuzione delle informazioni è fondamentale per registrare più informazioni possibili e spostarli nella parte alta è fondamentale, ragione per cui si usa lo spazio log di registrazione che spostando verso il centro le informazioni si cerca di conservare più informazioni possibili dai sensori.

Inoltre non tutti i sensori lavorano alle stesso modo tra luce e ombra, alcuni sensori, a partire dalla sensibilità Nativa distribuiscono la gamma dinamica in alto e in basso in modo non lineare, per cui ci sono camere in cui i 14 stop di gamma dinamica sono 9 in alto e 5 in basso, altre sono più equilibrate, dipende dal tipo di sensore, da come nasce e come è stato sviluppato.

Molti possono pensare ai problemi di grip, di come maneggiarle, dell’audio, della qualità di registrazione ridotta, ma quelli sono solo dettagli, ci sono mille e più modi di gestire quelle limitazioni…

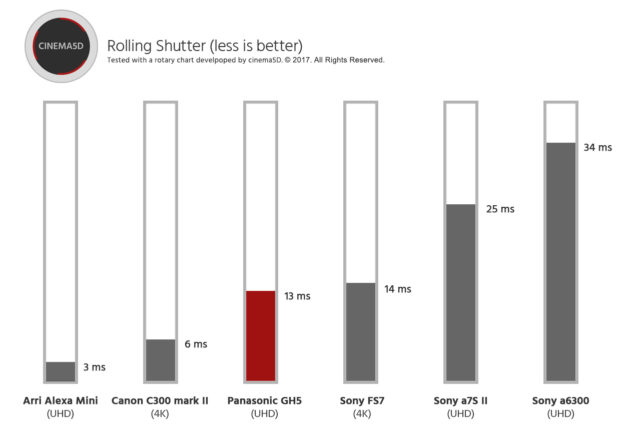

Molti possono pensare ai problemi di grip, di come maneggiarle, dell’audio, della qualità di registrazione ridotta, ma quelli sono solo dettagli, ci sono mille e più modi di gestire quelle limitazioni… La informazione che a molti manca è il fatto che il Rolling Shutter potrebbe non essere un problema, visto che la Alexa, cinepresa Arriflex standard per il 90% della produzione cinema, usa la tecnologia rolling shutter, ma con una latenza di 3ms quindi non si genera il problema dell’effetto Jellow, mentre nelle fotocamere spesso abbiamo tempi più lunghi di latenza e quindi si genera il problema.

La informazione che a molti manca è il fatto che il Rolling Shutter potrebbe non essere un problema, visto che la Alexa, cinepresa Arriflex standard per il 90% della produzione cinema, usa la tecnologia rolling shutter, ma con una latenza di 3ms quindi non si genera il problema dell’effetto Jellow, mentre nelle fotocamere spesso abbiamo tempi più lunghi di latenza e quindi si genera il problema.