E’ ironico notare come spesso la critica parli male di un genere che dà spesso l’occasione agli attori di emergere : l’Horror

Il genere spesso ricade nel low budget, soprattutto rispetto alle produzioni classiche, quindi gli attori emergenti spesso fanno delle parti nel genere dove nomi più altisonanti non sono gestibili con i budget ridotti del genere Horror.

Qualche nome? Giusto per non cadere nel generico, o parlare di attori che poi sono noti solo agli amanti del genere? E comunque ogni grande attore ha avuto la sua capatina nel genere, più o meno nobile dell’horror.

- Angelina Voight Jolie esordisce nel fantahorror del 1993 Cyborg 2 glass shadow

- Brad Pitt esordisce giovanissimo, ma la sua stella inizia a brillare con Intervista col vampiro nel 1994 con Tom Cruise

- Charlize Theron, oggi riconosciuta grande attrice dopo l’oscar di Monster e l’interpretazione in MadMax Fury Road, ha esordito in The children of the corn III

- Clint Eastwood esordisce nel 1955 La vendetta del mostro della laguna nera e nello stesso anno anche nel film Tarantula di Jack Arnold

- Demi Moore, prima di ghost era nel fanta horror trash del 1980 Parasite

- George Clooney è giovanissimo quando appare nella commedia horror Il ritorno dei pomodori assassini nel 1988, e prima ancora in Grizzly II 1983 , e ancora prima La scuola degli Orrori 1987

- Julianne Moore prima di essere la cacciatrice di Hannibal Lecter era Susan ne I delitti del gatto nero (1990), la dark Lady Connie Stone nel Noir soprannaturale Omicidi e incantesimi (1991), tornando spesso nel genere come nel 2013 nel remake di Carrie lo sguardo di Satana,

- Il grande Jack Nicholson, iniziò nel 1960 nella Piccola bottega degli orrori, per arrivare ad essere diretto da Kubrik nel 1980 in The Shining, fino a trasformarsi poi in Lupo mannaro nel 1994 in Wolf

- Jamie Lee Curtis è una delle prime donne che rivoluzionano l’assioma vittima carnefice nel 1978 in Halloween di John Carpenter

- Jennifer Aniston nel 1993 è spaventata a morte dal Leprechaun prima ancora di essere Rachel di Friends

- Johnny Deep prima di essere il feticcio di Tim Burton e Jack Sparrow era una delle prime vittime di Freddy Krueger in Nightmare on Elm street del 1984

- John Travolta, prima delle febbre del sabato sera, faceva i suoi primi passi sul set di Carrie di Brian de Palma

- Kate winslet, prima di salire sul Titanic per interpretare Rose, era stata una delle muse del fantahorror di Peter Jackson Creature del cielo nel 1994

- Keanu Reeves, prima di essere immortalato in Matrix, prima di essere la star di azione con Speed, e poco dopo essersi trasformato in un sex symbol in Point Break, è interpretando Jonathan Harker in Dracula di Coppola nel 1992 che diventa un mito

- Kevin Bacon ha l’onore di essere una delle prime vittime di Jason nel 1980 in Venerdì 13

- Leonardo di Caprio prima di essere il divo di MrGraves e Titanic combatte i criceti spaziali in Critters 3 nel 1991

- Liam Neeson prima di essere consacrato al grande pubblico con Schindlers’ List era il dott Peyton WestLake, il supereroe horror di Sam Raimi Darkman del 1990, e ancor prima, nel 1988, nella commedia fanta horror High Spirits con Peter O’Toole e Daryl Hannah

- Linda Hamilton, prima di abbattere Terminator, era presente nel 1979 in Wishman, e poi era la protagonista in Children of the Corn 1984 prima di girare il primo Terminator

- Luke Perry, che in tv è il Dylan dietro cui tutte le ragazzine morivano, al cinema esordisce un paio di anni dopo, nel 1992 con il film di Buffy l’ammazzavampiri

- Meg Ryan prima di essere la fidanzatina d’america era l’amichetta della bimba nella casa infestata di Amitiville 3 D

- Michelle Pfeiffer frequenta da sempre il genere, la vogliamo ricordiamo per Scarface 1983, o per essere stata la deliziosa Isaboe in LadyHawk, o Sukie Ridgemont in Le streghe di Eastwick, per poi diventare una affascinante lupa mannara in Wolf in compagnia di Jack Nicholson, e poi ancora in Dark Shadow di Burton,

- Mila Kunis affronta nel 1995 in piranha per farsi largo nell’oceano del cinema

- Robert De niro, anche se non a inizio carriera, non ha disdegnato l’interpretazione del mostro di Frankestein, in contrapposizione al dottore, interpretato da Kenneth Branagh nell’omonimo film Mary Shelley’s Frankenstein

- Sam Elliot nel 1972 si lancia col film Frogs

- Scarlett Johansson prima di diventare la Vedova Nera era una teenager nel film di genere Arac Attack nel 2002

- Sharon Stone nel 1981 viene portata alla ribalta da Wes Craven in Benedizione mortale

- Sigurney Weaver aveva già fatto qualche film, ma il masterpiece che l’ha lanciata è stato il primo Alien di Scott nel 1979

- Tim Curry, istrionico, versatile artista ha attraversato ogni genere e personaggio, ma per i più resta il dott Frank-o-furter di The Rocky Horror Picture Show

- Tom Cruise era già noto al grande pubblico con risky business, ma il salto di qualità lo fa diretto da Ridley Scott in Legend

- Tom Hanks esordisce nel 1980 in he know you are alone

- Winona Ryder deve il suo lancio alla commedia horror BeetleJuice di Tim Burton nel 1988 e poi in Dracula di Coppola nel 1992

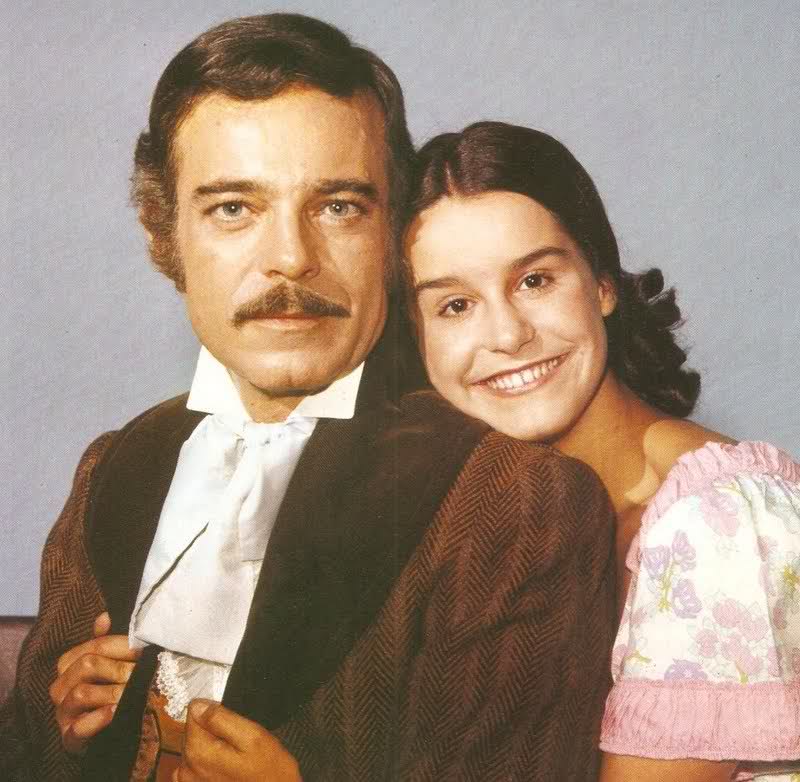

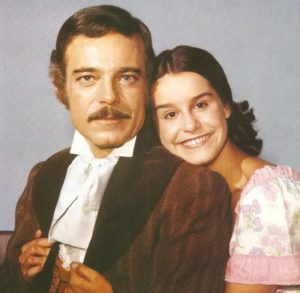

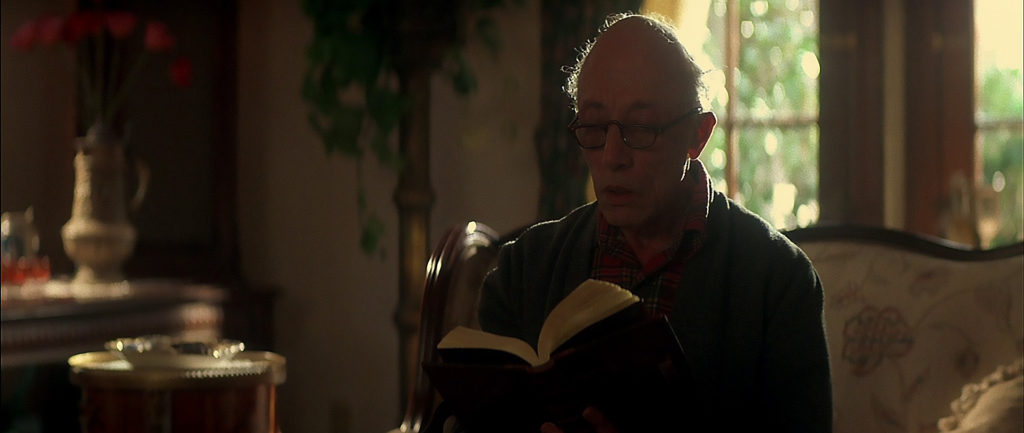

- il nostrano Zingaretti esordisce in una produzione horror italo americana Castle freak.

Insomma questa piccola carrellata per ricordare come il cinema di genere horror sia sempre stato prolifico di attori, registi, etc ma spesso si ricordano per le altre interpretazioni… dopo tutto già alla nascita del cinema si possono contare un sacco di horror, nel 1890 …