Oggi con la fisima della nitidezza e della definizione inoculata dal marketing, se non abbiamo un telefono che riprende in 8k (per mostrarlo sul display magari neanche fullhd, compresso), se non facciamo riprese panoramiche da 12k (combo di Newyork girato con 3 red 8k), non abbiamo immagini definite.

Dall’altra parte abbiamo persone che fanno studi scientifici sulla capacità visiva dell’occhio e confrontando in modo diretto le immagini delle diverse camere dimostrano che a parità di pixel non è detto che abbiamo realmente immagini più definite, anzi in certi casi diventa il contrario, motivo per cui Arriflex con la sua Alexa, 2,7k e 3.4k in openGate spesso offre immagini più nitide di quelle catturate con cineprese digitali 8k.

Senza fare il pixel peeper, lasciando queste seghe mentali ad altre persone, visto che il mio obiettivo primario è la narrazione per immagini, vediamo di capire brevemente quali sono i fattori che permettono di esprimere al meglio la nitidezza e l’acutezza di una ripresa (indipendentemente da fattori umani).

fattore 1 : la lente

La lente può (condizionale) determinare la qualità dell’immagine perchè è il sistema con cui si cattura la luce, la focalizza e la proietta sul piano focale (pellicola o sensore). La qualità delle lenti oggi è abbastanza lineare, per cui la differenza può essere la luminosità della lente, ma usata nel modo corretto (vedi il fattore 2), una lente media offre una buona definizione senza dare grandi limitazioni sulla nitidezza, a patto che :

La lente può (condizionale) determinare la qualità dell’immagine perchè è il sistema con cui si cattura la luce, la focalizza e la proietta sul piano focale (pellicola o sensore). La qualità delle lenti oggi è abbastanza lineare, per cui la differenza può essere la luminosità della lente, ma usata nel modo corretto (vedi il fattore 2), una lente media offre una buona definizione senza dare grandi limitazioni sulla nitidezza, a patto che :

- la lente sia pulita e non abbia elementi estranei sopra

- che non ci sia luce laterale (non protetta da paraluce e mattebox) che abbatte il contrasto

- che non ci siano filtri di bassa qualità che riducono la definizione iniziale della lente, spesso si usano filtri neutri di qualità non ottimale, che riducendo la luce la diffondono togliendo nitidezza all’immagine originale.

- che sia correttamente calibrata per proiettare sul sensore l’immagine (alcune lenti soffrono di problemi di pre/back focus, ovvero l’immagine viene proiettata poco prima o poco dopo il piano focale, quindi per centesimi di mm di tolleranza l’immagine è più morbida perchè non allineata col piano focale

- che la lente sia perfettamente allineata (in alcuni casi le lenti possono essere leggermente angolate rispetto al piano focale causando una perdita di definizione su uno dei lati in alto, o in basso, o a destra, o a sinistra.

In un precedente articolo avevo fatto una disanima tra diverse lenti, da lenti vintage a lenti medie, e una lente di fascia più alta senza riscontrare una differenza di nitidezza percepibile nell’uso comparato: stesso diaframma, stessa situazione, stesso sensore, stesso soggetto.

fattore 2 : il diaframma

Quando si gestisce la ripresa troppe persone dimenticano che le regole di fotografia valgono sempre, indipendentemente dalla qualità dell’attrezzatura. Molti oggi sanno che il diaframma gestisce la luce in ingresso definendo se farne entrare tanta o poca, e di conseguenza alterando anche la profondità di campo. Ho spiegato in modo più esteso in un altro articolo sull’esposizione questo discorso, ma in molti non sanno come cambiando il diaframma si possa entrare in un campo di alterazione della luce che genera la DIFFRAZIONE e come possa essere il limite della propria ripresa.

In breve cosa è la diffrazione?

Quando si chiude il diaframma di un valore maggiore di X il dettaglio di luce proiettato sul diaframma non si concentra ma si diffonde, per cui un punto chiaro su una superficie scura non è più nitido ma sfuocato. Tradotto in soldoni c’è troppa luce e chiudo il diaframma pensando di ridurla, ma man mano che chiudo il diaframma perdo nitidezza, quindi a diaframma 22 la stessa immagine sarà sfuocata rispetto a diaframma 11 come se avessimo applicato un filtro di diffusione o di blur.

Come si gestisce la diffrazione?

Dato che la diffrazione appare da un certo diaframma in poi si tratta di scoprire quale sia il diaframma limite della propria lente, in funzione del proprio sensore. Un semplice e comodo calcolatore di diffrazione lo potete trovare in questo interessante articolo sulle lenti e le loro caratteristiche.

Comunque per semplificare la vita a molti di noi, una semplice tabella per avere un riferimento, poi da lente a lente può esserci più tolleranza.

Risoluzione vs Dimensione

| Risoluzione Sensore | Sensore 4/3 | Sensore s35 | Sensore 24×36 |

| FULL HD | f/18 | f/26 | f/32 |

| 4k | f/9.9 | f/12 | f/18 |

| 4.6k (UMP) | f/11 | ||

| 5.7k (eva1) | f/8.8 | ||

| 8k (Red Helium) | f/9.4 |

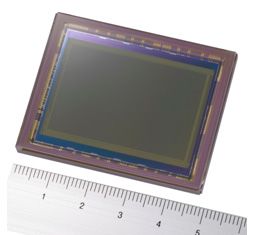

Come si può notare non si parla di diaframmi particolarmente chiusi, se non alle basse risoluzioni, il che diventa particolarmente divertente notare come con l’aumentare della risoluzione si abbassa la possibilità di chiudere il diaframma, altrimenti si crea diffrazione, catturando una immagine progressivamente più sfuocata pur aumentando il numero di pixel catturati. Attenzione che per risoluzione si intende la risoluzione del sensore, non della cattura del filmato, perchè la dimensione dei fotodiodi o dell’elemento che cattura la luce influenza in modo diretto la nitidezza delle immagini.

Per questa ragione quando si lavora con le cineprese digitali il filtro neutro è un elemento fondamentale e indispensabile per preservare la nitidezza originale, e contrariamente a quello che credono molte persone, le dslr non sono così comode avendo un gran numero di pixel da cui ricavare un formato fhd, perchè se usiamo una fotocamera che registra in fhd ma il sensore è un 24mpx, quello è il limite da usare per scegliere il diaframma di ripresa e mantenere il massimo della nitidezza possibile, a questo proposito la mirrorless ottimale per il video è quella creata da sony nella serie A7s perchè pur usando un sensore fullframe ha una risoluzione di ripresa corrispondente all’output, ovvero 4k, e quindi meno sensibile alla diffrazione di una A7r che con 36 e 54 mpx tenderà ad avere il triplo e il quintuplo dei problemi.

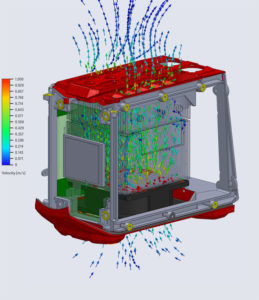

fattore 3: il sensore

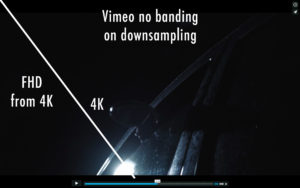

Il sensore, la sua tipologia, la sua risoluzione possono influenzare la nitidezza catturata, quindi ovviamente se il sensore è a misura della risoluzione di uscita il risultato sarà migliore. La maggior parte dei sensori sono strutturati da una matrice detta Bayer, nella quale si cattura un segnale monocromatico e poi filtrandolo si ricavano i colori, per cui abbiamo il verde che rappresenta la luminanza che possiede buona parte delle informazioni, mentre gli altri due colori sono ricavati ecatturati parzialmente, per cui si dice che comunque un sensore xK abbia una reale risoluzione di 2/3 dei K originali e poi venga fatto l’upsampling effettivo dei pixel. Il che tecnicamente è vero, ma non è un reale problema. Esistono sensori fatti come wafer dei tre sensori (uno per colore) che catturano separatamente le componenti colore RGB che spesso offrono immagini di ottima nitidezza. Esiste poi la scuola di pensiero del downsampling, ovvero catturiamo con un sensore di dimensioni maggiori, ad esempio 4.6k, 5,7k e poi da questo ricaviamo alla fine un segnale in 4k o 2k o fhd, in modo da sovracampionare le informazioni e avere una maggior precisione e dettaglio. La semplice prova di forza o applicazione muscolare degli X k non è fonte sicura di qualità o di dettaglio, inoltre con l’aumentare della risoluzione e non delle dimensioni del sensore incontriamo il problema della Diffrazione (come abbiamo visto prima), e il problema della sensibilità, perchè la stessa lente deve distribuire la stessa luce su un numero maggiore di fotorecettori, quindi ogni elemento riceve meno luce o con meno intensità.

Il sensore, la sua tipologia, la sua risoluzione possono influenzare la nitidezza catturata, quindi ovviamente se il sensore è a misura della risoluzione di uscita il risultato sarà migliore. La maggior parte dei sensori sono strutturati da una matrice detta Bayer, nella quale si cattura un segnale monocromatico e poi filtrandolo si ricavano i colori, per cui abbiamo il verde che rappresenta la luminanza che possiede buona parte delle informazioni, mentre gli altri due colori sono ricavati ecatturati parzialmente, per cui si dice che comunque un sensore xK abbia una reale risoluzione di 2/3 dei K originali e poi venga fatto l’upsampling effettivo dei pixel. Il che tecnicamente è vero, ma non è un reale problema. Esistono sensori fatti come wafer dei tre sensori (uno per colore) che catturano separatamente le componenti colore RGB che spesso offrono immagini di ottima nitidezza. Esiste poi la scuola di pensiero del downsampling, ovvero catturiamo con un sensore di dimensioni maggiori, ad esempio 4.6k, 5,7k e poi da questo ricaviamo alla fine un segnale in 4k o 2k o fhd, in modo da sovracampionare le informazioni e avere una maggior precisione e dettaglio. La semplice prova di forza o applicazione muscolare degli X k non è fonte sicura di qualità o di dettaglio, inoltre con l’aumentare della risoluzione e non delle dimensioni del sensore incontriamo il problema della Diffrazione (come abbiamo visto prima), e il problema della sensibilità, perchè la stessa lente deve distribuire la stessa luce su un numero maggiore di fotorecettori, quindi ogni elemento riceve meno luce o con meno intensità.

A livello teorico maggior numero di pixel correttamente gestiti nella cattura può corrispondere ad un maggior numero di dettagli, a patto che utilizzi la risoluzione reale del sensore, cioè i pixel catturati siano esattamente la matrice del sensore.

Le eventuali elaborazione del segnale prima della registrazione (raw o sviluppata) possono inficiare la nitidezza del segnale. Esistono diversi tipi di amplificazione del segnale e durante quella fase (analogica o digitale) si può alterare la percezione di nitidezza.

fattore 4: la compressione

Una volta catturate le informazioni, queste devono essere in qualche modo registrate, e pur partendo da sensori con un’alta capacità di cattura di dettaglio, o d’informazioni (spesso 16bit lineari) poi la registrazione delle informazioni viene ridotta a 14-12bit raw o 10bit compressi con algoritmi varii che per ridurre il peso dei file andrà a alterare in modo più o meno significativo le nitidezza delle immagini. Ogni camera ha i suoi algoritmi di compressione, molti nelle cineprese si basano sul concetto della compressione wavelet, che sia raw o no, per impedire la formazione di blocchi di tipologia più “digitale” come la compressione mpeg che genera blocchi di dati a matrici quadrate, questo ottimo tipo di trasformata nel momento in cui si comprimono i dati tende man mano che si aumenta la compressione a rendere più morbido il filmato. Naturalmente quando si parla di morbidezza parliamo di finezze, non certo di avere immagini sfuocate. Molti Dop quando usano le camere Red scelgono di usare compressioni più o meno spinte in alternativa all’uso di alcuni filtri diffusori per rendere più piacevoli le immagini.

Quindi facendo una ripresa o una fotografia, non possiamo strizzare i dati in poco spazio e pretendere di avere il massimo delle informazioni, del dettaglio, della definizione. La scelta dei formati di compressione è molto importante e conoscere le differenze tra i diversi formati di compressione e le loro tecnologie applicate alle diverse camere è importante per poter gestire correttamente la qualità di partenza iniziale. Alcuni formati a compressione maggiore (h264/5) generano artefatti a blocchi, mentre le gestioni dei formati wavelet possono ridurre la nitidezza dell’immagine man mano che si aumenta la compressione, ma in modo molto leggero, tanto che molte compressioni wavelet vengono definite visually lossless

fattore 5: la lavorazione

Le lavorazioni dei file possono alterare la percezione della nitidezza se vengono create più generazioni dei file originali non utilizzando formati DI di qualità per lo scambio e l’esportazione dei materiali. L’applicazione di effetti o lavorazioni con sistemi non professionali può causare ricompressioni non volute, downscaling e downsampling colore che possono influenzare la nitidezza originale. Inoltre ci sono fasi molto delicate come il denoise che in certi casi può essere troppo forte o troppo aggressivo e come tale tende a mangiare non solo il rumore, ma anche il dettaglio fine.

fattore 6: il delivery

Un fattore poco conosciuto è la scalatura dinamica dei flussi video, soprattutto quando si guardano i film in streaming legale. Il file alla fonte ha una risoluzione e una compressione, ma durante la trasmissione se ci sono problemi di segnale, rallentamenti, problematiche varie il segnale viene

Un fattore poco conosciuto è la scalatura dinamica dei flussi video, soprattutto quando si guardano i film in streaming legale. Il file alla fonte ha una risoluzione e una compressione, ma durante la trasmissione se ci sono problemi di segnale, rallentamenti, problematiche varie il segnale viene  istantaneamente scalato per impedire che il filmato vada a scatti o in qualche modo possa influire sulla visione generale, quindi da una scena all’altra potrebbero esserci delle variazioni consistenti della qualità e i sistemi di contrasto dinamico andrebbero ad amplificare ulteriormente i bassi dettagli. Se abbiamo un prodotto stabile e lineare come un bluray o un bluray 4k abbiamo la certezza che la qualità sarà sempre costante, mentre se usiamo una distribuzione differente delle perdite di qualità potrebbero essere causate dalla trasmissione variabile.

istantaneamente scalato per impedire che il filmato vada a scatti o in qualche modo possa influire sulla visione generale, quindi da una scena all’altra potrebbero esserci delle variazioni consistenti della qualità e i sistemi di contrasto dinamico andrebbero ad amplificare ulteriormente i bassi dettagli. Se abbiamo un prodotto stabile e lineare come un bluray o un bluray 4k abbiamo la certezza che la qualità sarà sempre costante, mentre se usiamo una distribuzione differente delle perdite di qualità potrebbero essere causate dalla trasmissione variabile.

fattore 7: la fruizione

Un fattore che tanti sottovalutano, spesso causa del danno finale, sono i metodi di fruizione del materiale video. A partire dal dispositivo di visione, che spesso altera in modo più meno significativo l’immagine, vedi l’articolo sui televisori da telenovelas, al metodo di gestione delle informazioni. Quando vediamo una immagine non sappiano se il pannello è a misura per l’immagine che stiamo vedendo, il che può essere causa di alterazione di vario tipo, perchè dovrà essere scalata in realtime con diversi algoritmi più o meno efficienti nel mantenere il dettaglio o perderlo. Spesso abbiamo televisori 4k che mostrano materiale fhd (1/4 delle informazioni) o peggio sd (1/16 delle informazioni). Il danno però nasce dal fatto che tutti questi televisori applicano le funzioni di oversampling anche quando una immagine ha realmente la dimensione del pannello, quindi anche se apparentemente sembrano ancora più nitide, in realtà gli effetti dei vari algoritmi di sharpening tendono a creare nuovi “FINTI” dettagli che sovrascrivono e cancellano i dettagli originali.

Spesso ci sono tanti parametri attivati a nostra insaputa, o peggio abbiamo la difficoltà di disabilitarli, perchè solo in determinate combinazioni di visione sono modificabili. Ci sono prodotti di fascia alta che è possibile disabilitare le maschere di contrasto e i vari algoritmi di contrasto solo con i segnali in ingresso HDMI, non per i segnali interni o da stream internet interno… il che è può essere imbarazzante con i segnali 4k da Netflix che sono ottimi e non richiedono ulteriori process, anzi…