Da anni ci sono contenzioni tra gli amanti della pellicola e del digitale, di come uno o l’altro mezzo sia meglio per riprendere, che il cinema vero è solo quello girato in pellicola, etc etc.

Da anni ci sono contenzioni tra gli amanti della pellicola e del digitale, di come uno o l’altro mezzo sia meglio per riprendere, che il cinema vero è solo quello girato in pellicola, etc etc.

Personalmente sono dell’idea che se il mezzo condiziona la narrazione a tal punto, forse chi usa il mezzo è talmente scarso da far notare la sua carenza registica, di struttura e narrazione da far notare allo spettatore che si usa uno strumento piuttosto che l’altro, e male, visto che lo spettatore lo nota….

edito l’articolo perchè qualcuno che in un modo o nell’altro ha influenzato il mondo della produzione pellicola e digitale ha fatto un discorso interessante…

Comunque, visto che di solito sono discussioni che dovrebbero essere di natura tecnica, e si portano avanti esempi dei registi che oggi vogliono fare gli elitari usando la pellicola invece che i loro colleghi più “rustici” che usano il digitale come James Cameron, Spielberg, Coppola, Scorsese, Lucas e direi che bastano questi nomi per definire questi strani personaggi che s’incaponiscono nell’ usare il freddo e limitato cinema digitale… che gentaglia… vediamo di capire realmente a livello tecnico quali sono i pro e i contro dei due media.

Quando si parla di pellicola vs digitale si devono portare termini di paragone coerenti, per cui se parlo di una vdlrs devo paragonarla ad 16mm granulosa, non certo ad una s35 80 asa… come quando parlo della Pellicola si deve vedere quale pellicola, quale emulsione e in quali condizioni la facciamo lavorare contro una cinepresa digitale di fascia paragonabile, altrimenti è facile vincere un confronto se metto una Ferrari a fianco ad una utilitaria base col freno a mano tirato.

Partiamo da una premessa tecnico pratica : il cinema è cinema perchè la luce, l’inquadratura, le lenti e tutto l’insieme del processo è curato dall’inizio alla fine, se poniamo una ottima pellicola in assenza di luce o in low light, la si espone male, la si tira come sensibilità, si pone una cattiva lente davanti, viene sviluppata male, la stampa finale viene curata alla buona e il proiettore pellicola non è nello stato di grazia, l’immagine sarà BRUTTA, Granulosa, chiusa, poco definita, insomma non cinematografica.

Se poniamo un sensore digitale di buon livello in condizioni di luce ottimali (come si fa al cinema) avremo immagini cinematografiche di ottima qualità, che mescolate a riprese fatte in pellicola non si distinguerà da essa (succede più spesso di quanto credano i detrattori del digitale, ma non lo sanno).

La pellicola, per come funziona l’emulsione, il suo costo, il metodo (unico) di lavorazione non permette sbagli, per tale ragione chi usa la pellicola la lavora al meglio, e quindi ottiene il meglio delle immagini. Per chi ha dubbi cerchi qualche filmino di famiglia s8 o 16mm e vediamo se la qualità amatoriale delle immagini viene “salvata” miracolosamente dal fatto che è stata usata la pellicola al posto del digitale, se le immagini sono perfette, le esposizioni magicamente di bilanciano, la profondità delle immagini (non la sfuocatura) appare perchè è la pellicola a fare tutta la magia…

Sono abbastanza stanco di sentir dire che la pellicola è meglio, ha più gamma dinamica (da gente che non sa neanche cosa sia la gamma dinamica) del digitale, che è più naturale (in teoria sarebbe vero ma solo a determinate condizioni, leggere in coda la parte relativa alla visione delle immagini), contro il freddo sistema digitale. Sono due mezzi diversi, ma a seconda delle situazioni, uno ha vantaggi rispetto all’altro.

Vantaggi :

Ripresa in Pellicola :

- Cambiando il rullo con la stessa macchina si può lavorare con sensibilità diverse reali (nel digitale sono simulate).

- In caso di lavorazioni in situazioni estreme la pellicola in modalità completamente meccanica può lavorare dove il digitale può fermarsi (freddo caldo campi magnetici etc).

- La capacità di catturare più o meno contrasto (gamma dinamica) la si può cambiare con il cambio pellicola (nel digitale si deve cambiare corpo macchina).

- Non esistono problemi legati alla cattura delle immagini in movimento veloce nè distorsioni date dalla lettura delle immagini (alcuni sistemi di ripresa digitale li hanno vedi rolling shutter e simili)

- E’ uno standard da 100 anni e le regole di lavoro sono consolidate e note, raggiungibili anche dai non addetti ai lavori in brevi ricerche.

Ripresa in Digitale :

- Si può vedere in real time quello che sarà catturato e rivedere subito esattamente quello che si è catturato in camera.

- ha un costo leggermente più basso della pellicola per ripresa (a livello professionale con un girato che pesa 20 giga al minuto per ogni camera, quindi lo spazio su dischi e chi gestisce il flusso dati sono un costo da aggiungere e da considerare).

- Si possono controllare al volo gli effetti per riprese multiple di vario tipo.

- Una cinepresa digitale di basso livello, ma ad alta qualità è abbordabile anche da un filmaker, una cinepresa 35mm ma soprattutto la pellicola non lo sarebbe mai.

- Alcune macchine simulano esposizioni a iso più alti che possono aiutare a comprendere meglio come gestire la scena in post o a riprendere ove non è possibile (Lubesky scelse la Alexa per poter avere un’ora in più di luce naturale per The Revenant).

- Sul set si possono generare copie identiche del negativo digitale, per ovviare ai rischi di danneggiamento o perdita delle riprese, cosa non possibile con la pellicola

La gamma dinamica della pellicola

Quelli che vedete qui sotto sono range dinamici pubblicati o stimati di pellicola e dispositivi digitali. Naturalmente si parla della capacità migliore di cattura dell’immagine nella situazione migliore, ma se non ci sarà abbastanza luce, se non saranno riempite correttamente le ombre etc, la gamma dinamica si riduce notevolmente.

Tmax 400 film (0.58 CI) 3.4d 19.5 stops Pellicola fotografica bianco e nero

Tmax 100 film (0.58 CI) 3.0d 17 stops Pellicola fotografica bianco e nero

Tri-X 35mm film (0.58 CI) 2.4d 13.5 stops Pellicola fotografica bianco e nero

Tri-X 35mm film (0.75 CI) 2.4d 10.5 stops Pellicola fotografica bianco e nero

Kodachrome 25, 64, 200 (1.4 gamma) 3.7d 8 stops Pellicola fotografica colori

Ektachrome 100 (1.4 gamma) 3.4d 7.5 stops Pellicola fotografica colori

KODAK VISION3 500T Color Negative Film 5219 / 7219 14-15 stops pellicola cinematografica

Human eye (no iris change) 150:1 7 stops

Arriflex Alexa, Alexa 65, Amira 14 stops

Red Scarlet, Raven, Epic, Weapon 16,5 stops

BlackMagicDesign Cinema Camera 14 stop

BlackMagicDesign Cinema Camera 4K 13 stop

Come si può vedere tra la pellicola cinematografica classica e le cineprese digitali di alto (red e arriflex) e basso (digital bolex, kineinfinity e Blackmagic) non ci sono delle differenze reali, ma al contrario siamo esattamente nello stesso range, addirittura diverse red hanno un range ancora più ampio. Questo non significa che il digitale sia meglio della pellicola, ma semplicemente possiamo ottenere gli stessi risultati.

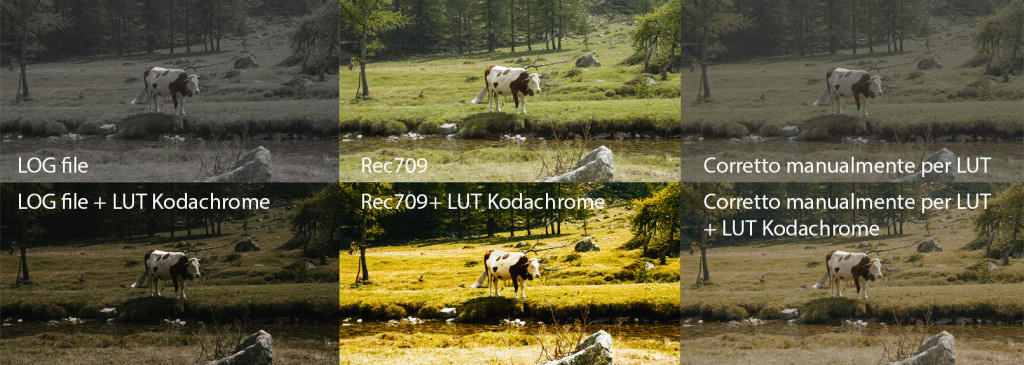

Perchè la ripresa in pellicola sembra sempre migliore del digitale?

se si pongono i due media nella stessa condizione di catturare la stessa luce, queste macchine lavoreranno nello stesso modo e vi daranno la possibilità di catturare la stessa immagine, quello che di solito capita è che la pellicola costa, e nessun dilettante può permettersi di giocare con 16 o 35mm quindi quel tipo di cinepresa lavorerà in situazione professionale con persone che sanno usare, esporre, gestire la pellicola per farla rendere al meglio, mentre il digitale con i suoi teorici automatismi da l’illusione che chiunque noleggi una red per un giorno possa tirar fuori delle immagini cinematografiche, senza curare luce, contrasto, scenografia costumi, trucco etc…

se si pongono i due media nella stessa condizione di catturare la stessa luce, queste macchine lavoreranno nello stesso modo e vi daranno la possibilità di catturare la stessa immagine, quello che di solito capita è che la pellicola costa, e nessun dilettante può permettersi di giocare con 16 o 35mm quindi quel tipo di cinepresa lavorerà in situazione professionale con persone che sanno usare, esporre, gestire la pellicola per farla rendere al meglio, mentre il digitale con i suoi teorici automatismi da l’illusione che chiunque noleggi una red per un giorno possa tirar fuori delle immagini cinematografiche, senza curare luce, contrasto, scenografia costumi, trucco etc…

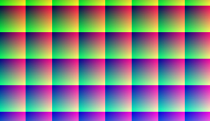

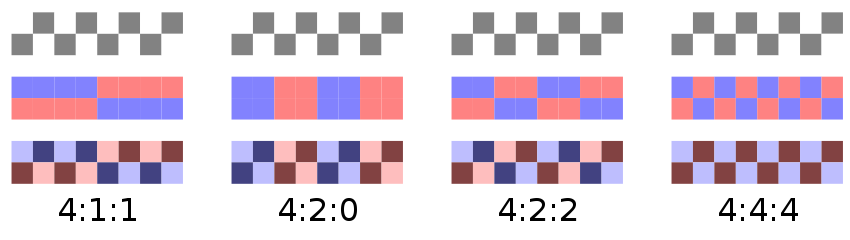

Il digitale rispetto alla pellicola non è uno, ma tanti modi di catturare le informazioni e se non vengono catturate tutte (raw o almeno in log a 10bit) bisogna saperle trattare e gestire per evitare la nascita di difetti, artefatti o castrature varie alle informazioni originali, e questo causa poi cattive recensioni alle macchine e al digitale di per se. Chiunque ha dubbi suggerisco di fare una semplice prova, si compri un rullo di 16mm e affitti una buona arriflex, una coppia di lenti 35-50mm zeiss e faccia una prova di ripresa in basse luci, la faccia sviluppare e vediamo se è la pellicola a fare il miracolo o è la bravura del direttore di fotografia a far catturare tutte le informazioni necessarie.

Diciamo che la visione della ripresa in pellicola è migliore della visione digitale, che forse è la grande differenza in cui si percepisce molto meglio tutto il risultato.

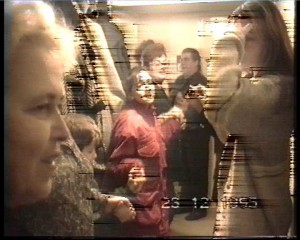

Inoltre la grana della pellicola offre una particolare percezione dell’immagine, che essendo diversa da un fotogramma all’altro non è direttamente percepibile dal cervello, ma ha una struttura organica piacevole che “amalgama” l’immagine, che non è replicabile con la semplice applicazione della grana in post, che spesso è statica o non proporzionale alla luminosità dell’immagine come con la pellicola.

La visione delle immagini Pellicola vs digitale

è fondamentale fare un chiarimento per il quale pur preferendo girare in digitale preferisco la proiezione in PELLICOLA :

quello che cambia è la percezione delle immagini e non il mezzo con cui le catturiamo a fare la differenza.

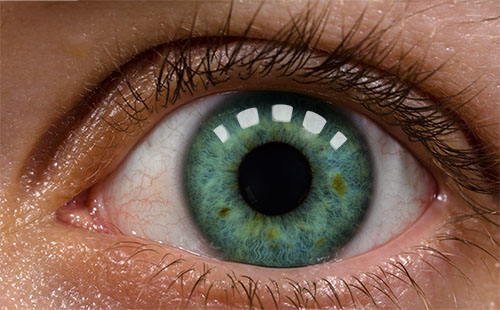

parliamo di come il nostro occhio vede il mondo reale :

la luce viene catturata dal nostro occhio, il cervello in micromillesimi di secondo apre e chiude la pupilla dilatando o no l’iride per recepire un maggior numero di informazioni, in pratica quello che Paul Devebec ha inventato negli anni 90 con le fotografie stratificandole per creare una HDR, l’occhio umano lo fa da milioni di anni, perchè l’occhio umano di per se ha la capacità di percepire una gamma dinamica più limitata, ma dato che in microsecondi aggiusta “l’esposizione” passa da circa 7 a 100 stop di gamma dinamica.

Quando un occhio percepisce un’ immagine questa si imprime sulla retina per un periodo X che si chiama persistenza retinica, questo periodo è diverso a seconda delle persone, il valore medio è quello che permette a tutti di vedere 24 fotogrammi al secondo e percepire il movimento corretto e fluido.

Quando si vede una immagine da pellicola il proiettore compie una azione ben precisa :

1/48 mostra l’immagine proiettata sullo schermo, 1/48 chiude il fascio di luce per passare al fotogramma successivo.

Questa alternanza tra luce e buio veloce fa si che l’immagine persistente sulla retina si abbassi come luminosità prima dell’arrivo della successiva, e si fonda con la successiva creando una alternanza più piacevole e quindi il movimento, il cambio d’inquadratura e tutto il resto funzioni meglio. Non a caso il sistema di visione principale della televisione nasce come interlacciato per fondere i fotogrammi tra di loro e dar loro maggior fluidità.

La proiezione digitale comporta invece una alternanza dei fotogrammi senza lo spegnimento tra un frame e l’altro e questo fa si che l’immagine sia si più luminosa, ma mancando questo processo di alternanza della luce le immagini possano più facilmente presentare effetti stroboscopici o problemi negli stacchi. I nuovi proiettori digitali come le nuove cineprese (arriflex) ripresentano il principio dell’otturatore a farfalla che mima questo processo, anche se non necessario come per la pellicola, ma fondamentale per i risultati di visione e percezione corretta delle immagini.

Se si riprende in digitale e si proietta in pellicola si ha la certezza che per quanto possano rovinare la pellicola o sottoalimentare la lampada colori e tutto il resto saranno abbastanza fedeli al progetto originale, mentre oggi come oggi i proiettori digitali potrebbero essere manipolati e ulteriormente mal tarati come luminosità etc da fare più danni alla proiezione, senza contare che chi ha comprato un proiettore digitale con i vari incentivi statali nel 2009 (lancio di Avatar e il 3d) di sicuro oggi non spende soldi per cambiarlo con uno con otturatore a farfalla solo perchè si vede meglio, anzi facilmente sottoalimenterà la lampada, come si faceva con i vecchi proiettori a pellicola, per farla durare di più perchè ha un costo, e tanto la media degli spettatori non se ne accorgono … come non si accorgono di immagini tagliate sopra e sotto perchè proiettate con aspectratio sbagliato, colori sbagliati, audio sfasati e mille altri problemi.

Un tempo si aveva l’idea che creare un DCP (Digital Cinema Package) fosse un modo per creare una immagine del proprio film che tutti avrebbero visto allo stesso modo, purtroppo è vero fino ad un certo punto perchè si deve avere un proiettore tarato al meglio, correttamente tarato per schermo e distanza, lampada alimentata al 100% e schermo in scotchlite o equivalente moderno che restituisca in modo lineare la luce, altrimenti i risultati saranno x e quindi nuovamente avremo dei Delta di differenza sul contrasto, sulla luce, sul colore delle immagini.

Pellicola verso digitale o forse formato contro formato?

personalmente preferisco usare il mezzo che mi piace di più, che mi offre libertà creativa espressiva, quando ho iniziato a fotografare in pellicola più di 35 anni fà (ho iniziato da molto piccolo) ottenevo alcuni risultati, e all’epoca da dilettante credevo a chi mi diceva che per ottenere mezzi migliori si doveva cambiare la macchina fotografica, perchè ci voleva la macchina fotografica professionale, poi a 18 anni mi fu regalata una ottima reflex dai miei genitori, e ci fu un piccolo salto in avanti, ma non ottenevo quello che volevo, eppure avevo la macchina, avevo la pellicola…

con la pellicola, con i suoi costi, ho imparato ad inquadrare meglio, a gestire meglio l’attimo e catturare il momento, ma non ottenevo quello che volevo.

con il digitale, con la sua immediatezza ho imparato a illuminare meglio, a gestire in manuale la camera, e ottenere quello che volevo … scattando in pellicola, perchè all’epoca il digitale era più limitato come gamma dinamica, dettaglio e controllo delle immagini.

da qualche anno il digitale offre le stesse potenzialità della pellicola ma con tanti vantaggi, per cui chiunque voglia lavorare al meglio con il digitale o con la pellicola ha la possibilità di scegliere, sapendo quali sono i vantaggi di uno o dell’altro media.

Naturalmente come nella pellicola ci sono tanti formati a partire dal 8 e super 8 fino al 70mm e imax, anche nel digitale abbiamo formati low end e high end, quindi quando si vorrà fare un confronto, non si deve pensare di confrontare il 35mm cinematografico con la videocamera hd di scarso livello, ma si deve paragonare il materiale di pari livello, altrimenti è inutile.

Comunque per i fautori del digitale vs pellicola, vorrei ricordare che la pellicola per essere di alta qualità e definizione deve lavorare a bassi iso, infatti kodak basa la sua produzione principale su pellicola CINQUANTA iso, se proprio vogliamo spingere nel low light troviamo la splendida VISION3 500T Color Negative Film 5219/7219 della Kodak, una emulsione eccezionale che si può esporre a 500 senza timore di tirar su grana o altro, con una ottima risposta nelle alte luci, con un trattamento che riduce fortemente la presenza di grana visibile, ma che nelle condizioni dove il digitale di solito si spinge molto oltre, richiede luce, tanta luce… cosa che di solito i fautori della pellicola dimenticano, perchè tanta luce non è solo un problema logistico economico, ma anche di gestione a livello pratico, per nascondere le luci, per gestire i movimenti camera etc, quindi appannaggio solo di un certo tipo di film, di genere e budget.

La pellicola NON ESISTE a 12.800 iso… la pellicola cinematografica men che meno, questa è la più sensibile, ma in media si lavora tra i 250 e gli 80 iso, e la si deve trattare bene. Andrew Laszlo (famoso DoP), prese l’abitudine di tirare (forzare nello sviluppo) la pellicola per determinati film, per dare più l’idea di riprese documentaristiche per film come i Guerrieri della Notte, Rambo, I guerrieri della palude silenziosa; scelte fatte a priori, non come oggi che si fa tutto in post, perchè all’epoca non si poteva, o si partiva in un certo modo, o non si otteneva quel risultato.

Ma la pellicola non fa la magia?

Di recente Kodak ha deciso di rilanciare la pellicola s8, con una cinepresa con ausilii digitali, per gli amanti del genere.

Di recente Kodak ha deciso di rilanciare la pellicola s8, con una cinepresa con ausilii digitali, per gli amanti del genere.

Sono curioso di vedere i risultati di questo esperimento, Kodak vi aiuta vendendo una cinepresa semi amatoriale con LCD FullHD per vedere le immagini che state per riprendere, farà una scansione della pellicola che farete sviluppare, che vi fornirà con lo sviluppo del prodotto.

Sono curioso di vedere quanti compreranno per 750 $ una cinepresa s8 come quelle che si possono comprare usate a 50$, che registra su una cartuccia di pellicola il video, e l’audio su una scheda SD.

Ogni 3 minuti di ripresa tra acquisto cartuccia, sviluppo e scansione digitale COMPRESSA costa solo 80$. Poi si deve mettere a sinch con audio, perchè la card SD non si manda al laboratorio.

Il tutto per un prodotto che sarà tra sd e hd, perchè anche la scansione non compressa di una pellicola s8 da 50 asa non ha abbastanza linee per superare un buon 1280×720, non esistono fisicamente i dettagli, e dubito che abbiano pensato ad un meccanismo preciso come quello delle cineprese 16 o 35, per cui le oscillazioni della pellicola in scorrimento muoveranno il piano focale rendendo meno nitida l’immagine…

Si, ammetto sarcasmo, ma è scontato… oggi come oggi ha senso prendere una buona cinepresa meccanica 16mm, per le quali ottiche e meccaniche hanno un senso rispetto alla qualità offerta, ma una cinepresa s8 da quasi 1000$ a 80$ ogni 3 minuti la trovo ridicola…

ho fatto una ricerca veloce, una 16mm seria si trova usata tra i 150 e i 300 euro, una giuntatrice pellicola per 30 euro, se si fa una ricerca lavorare in 16mm costa poco meno del doppio ma con una vera qualità…

Uno dei grandi turningpoint della pellicola sta nel fattore di “devo pensare prima di fare”, ovvero dato che costa e le scelte in camera influenzano tutta la catena, si devono prendere delle decisioni, stabilire stile e risultati, il che fornisce sempre una resa migliore che postprodurre all’infinito, ve lo dice uno che di post ne fa e tanta…

Detto questo la mia cinepresa preferita lavora a 400 iso e illumino, e/o uso le luci per ottenere l’atmosfera che mi interessa, e direi che si possono ottenere risultati interessanti e piacevoli, anzi ammetto di avere una certa repulsione per gli eccessi di capacità luminosa perchè si va oltre le immagini naturali.

Comunque a 400 iso si possono catturare comunque immagini interessanti, e se cliccate sulla foto e vedete il file a dimensione originale ci sono tutti i dettagli che servono, e una sottile grana piacevole da vedere in movimento.

chiudiamo con qualche dettaglio sgradevole della pellicola che nessuno vi dice, ma molto inquietante per chi investe energie e denaro sulla pellicola…

- la pellicola che voi mandate a sviluppare non è garantita, se accade qualcosa durante un bagno, durante lo sviluppo un acido si degrada o altro, vi verrà restituita da contratto una quantità di rulli vergini pari al girato perso, nulla più… anche se vi chiamate Roger deakins e ci avete messo l’anima (motivo per cui è passato di recente al digitale dopo un incidente occorso durante lo shooting del suo ultimo film dei Fratelli Cohen).

- se durante la ripresa un elemento anche minuscolo graffia o danneggia l’emulsione voi lo saprete solo a sviluppo fatto, se va bene due o tre giorni dopo, se siete Micheal Bay, quindi magari gli attori sono in un altro paese quando vi accorgete di aver perso il vostro unico ciak buono

- Avete un unico negativo master, da tenere come sacro, da gestire con l’autoblindo, perchè da quello poi ricaverete il materiale per il film, e finchè non verrà digitalizzato (perchè tanto si passa sempre dal digitale, il taglio negativo si è abbandonato da anni e anni) ne avete uno solo, delicato e a rischio.

- se la pellicola per una qualunque ragione ha preso caldo, freddo, umido, avete una partita andata a male o altro non vi accorgerete di nulla durante le riprese…

- la pellicola è molto inquinante e smaltirla inquina l’ambiente non poco…

detto questo ho la mia bella scorta di negativi, pellicole, s8, 16mm in scatole a tenuta ermetica, con gel di silicone per proteggerli dall’umido, che ho digitalizzato per poterli rivedere. La mia Nikon 601 analogica è stata mandata in pensione diversi anni fa, anche se ogni tanto viene riesumata giusto per giocare col bianco e nero, ma trovando sempre più limiti nella pellicola, e interessandomi i risultati e non il mezzo con cui li ottengo, ormai è un oggetto da collezione.