Pur essendo un fautore del 4k per la ripresa, perchè offre molto materiale su cui lavorare, tanti vantaggi in ogni operazione di manipolazione del materiale, sono convinto che sia l’ennesima bufala del 21 secolo per vendere il nuovo televisore, i nuovi vecchi contenuti.

Perchè il 4k è inutile nei televisori, nei cellulari, nelle telecamere amatoriali?

senza parlare del fatto che se non viene usato per la postproduzione è uno spreco di risorse cpu del dispositivo di cattura, spazio di memoria occupato, surriscaldamento del dispositivo, il 4k su un dispositivo al di sotto di determinate dimensioni è uno spreco inutile. L’acutezza visiva di un essere umano medio è tale da percepire circa 1/10 mm a circa 50cm di distanza, considerato che un pannello 4k di dimensioni medio è una densità di 110 ppi, ovvero su un 40 pollici si parla di 4 punti per mm quadro, peccato che un 40 pollici si guarderà da almeno 150 cm dove la capacità risolutiva è scesa in media a 2-3mm, quindi ci sono ben dieci volte le informazioni percebili da un essere umano medio…

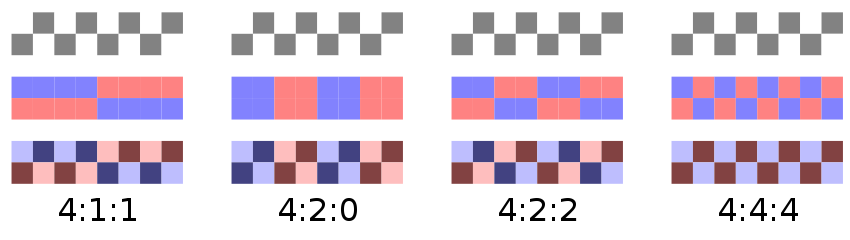

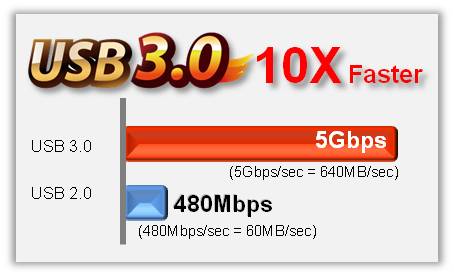

questo calcolo è valido esclusivamente se noi abbiamo una fonte 4k pura, perchè se su quel televisore vediamo un filmato 4k da streaming, youtube 4k, cellulare o altri elementi in realtà non avremo tutte quelle informazioni, perchè il pannello offre quella definizione, ma i dati trasmessi non li hanno, per cui il televisore sarà completamente inutile….

quindi perchè comprare un televisore 4k oggi?

Facciamo una analisi molte semplice e rapida dei pro e dei contro :

Pro:

- è una grande cornice digitale ad alta risoluzione per le vostre fotografie

- se ho una vera cinepresa digitale 4k posso vedere le immagini nel loro reale splendore, se sto molto vicino al 40 pollici che ho comprato.

Contro:

- non ci sono ancora contenuti veri in 4k con cui sfruttare una tv 4k

- lo standard bluray 4k è ancora teorico, ma non esistono bluray 4k in commercio

- non esistono ancora film girati completamente in 4k, quindi comunque si vedrebbero filmati “gonfiati” e non nativi 4k

- lo streming 4k in realtà offre meno di 2,7 k di risoluzione effettiva, il resto nasce per interpolazione quindi nuovamente inutile.

- la trasmissione 4k è teoria, in realtà ad oggi sono pochi i canali in FullHD (1920 x 1080), la maggior parte al max sono hd (1280×720).

- i televisori 4k non hanno decoder digitali per ricevere segnali 4k perchè non sono ancora stati definiti standard di trasmissione 4k, quindi al momento in cui esisteranno i canali 4k il nostro televisore sarà già obsoleto e non in grado di mostrare i filmati alla risoluzione 4k.

- la lettura di filmati FullHd offre una visione sfuocata dei contenuti (perchè gonfiata 4 volte) oppure troppo incisa perchè per mascherare l’immagine morbida viene processata mangiando in realtà diversi livelli di dettaglio durante le operazioni crude di sharpening. Quindi per vedere un bluray è un pessimo veicolo.

- costerà molto di più di un equivalente fullHD di qualità, non offrendo ad oggi la possibilità di vedere immagini realmente differenti.

- nel visualizzare immagini amatoriali 4k da cellulari, telecamere etc non è detto che esse abbiano sufficiente dettaglio per mostrare immagini di qualità per sfruttare la matrice 4k

- per percepire la reale differenza tra un tv 4k e un tv Fhd si deve andare dai 50 pollici in su, che però si dovranno vedere più da lontano e quindi si torna all’assurto iniziale, inutile per la maggior parte delle persone che non hanno la capacità visiva di apprezzarne il dettaglio a livello fisiologico.

perchè il 4k al cinema non serve?

la proiezione 4k è una piccola truffa, perchè in realtà la maggior parte dei film viene girata con cineprese digitali in 2k, come le alexa, per cui il fatto che venga poi proiettato in 4k non da nessun vantaggio di fatto, anzi, è un inutile flettere i muscoli di tutto il sistema, perchè richiederà 4 volte lo spazio originale del 2k, risorse maggiori per il play e la gestione dei contenuti senza dare un reale vantaggio.

Ma veramente non si vede la differenza?

Nolan si vantava di aver girato in Imax (formato in altissima definizione pellicola) l’ultimo cavaliere oscuro e Interstellar, e un sacco di gente ha detto di aver notato la differenza..

Sarei curioso di chiedere a quella stessa gente se mi sa indicare in quali inquadrature ha notato la differenza, perchè nessuno dei due è girato completamente in Imax, troppo costoso, troppo grandi e scomode le cineprese, etc etc… per cui sono state alternate le riprese di s35 tradizionali a quelle di imax (prettamente degli esterni dove era più semplice gestire macchine da presa più ingombranti)… soprattutto visto che queste pellicole nella maggior parte delle situazioni sono state viste in sale digitali su proiettori 2k, quindi dove tutto era appiattito e spostato verso il basso.

Altro punto a favore per l’impasto generale è dato dal fatto che molti film subendo digitalmente una postproduzione molto pesante, anche solo a livello di editing e color correction, non si è poi in grado di distinguere nelle riprese brevi fatte da dslr, go pro, telecamere, da cineprese professionali. Il tutto grazie al fatto che vengono utilizzate nella situazione migliore per estrapolare al meglio la qualità visiva dai diversi sensori facendole lavorare al meglio delle loro possibilità.

quindi per il 4k è presto?

beh si riprende in 4k per il futuro, perchè si estrae un 2k e un fullHD di altissima qualità, ma usare direttamente il 4k a livello domestico è uno spreco, perchè non è percepibile direttamente dall’occhio nella maggior parte delle situazioni domestiche.

perchè allora proliferano i televisori in 4k e tutte le periferiche 4k?

qualcosa vi devono vendere, o no?

Nel marketing si sono sempre usati i numeri per dare una percezione tangibile di un valore, anche se qui numeri non avevano reale connessione col valore del prodotto.

ad esempio, i masterizzatori sono partiti col 2x dei cd, fino ad arrivare a x52 dei dvd, ma nessuno vi dice che i supporti x52 non esistono, perchè la masterizzazione è un bilanciamento tra velocità di scrittura e numero di errori introdotti, a seconda della qualità del supporto la velocità viene dosata per introdurre un numero minimo di errori di scrittura, per permettere la lettura dei dati e grazie ad un sistema di correzione dell’errore poter risalire ai dati originali. Il concetto della correzione dell’errore di lettura era nato in origine per compensare i difetti di fabbricazione, e/o di graffi o i danni al supporto, nel tempo questo sistema è diventato un metodo per accelerare la scrittura sui supporti basandosi sul fatto che alla fine si riesce lo stesso a leggere i dati.

Il problema dove sta? nel fatto che se si porta un supporto al limite della leggibilità perchè lo vogliamo masterizzare a x52 invece che a x8, basta una leggera usura a rendere illeggibili i dati scritti. Non solo, la scrittura lenta applica in modo diverso il laser di scrittura e introducendo meno errori rende il supporto più resistente anche a usura più forte, esposizione a uv, deformazione del supporto scrivibile, etc.

Il che fa pensare su come in modo superficiale si scrivano dati su un supporto, senza aver avuto nozioni di come farlo e come conservarlo.. auguri ai masterizzatori da formula 1, forse dopo 3-4 mesi potranno ancora rileggere qualcosa dai loro supporti.

un altro esempio, i megapixel delle fotocamere:

da sempre sembra che i megapixel siano indice di qualità, ma se si schiacciano su un sensore da 1/4 di pollice 40 megapixel, non si può pensare di avere la stessa pulizia e luce di 12 megapixel su un sensore fullframe, perchè la luce catturata da ogni recettore è maggiore. In realtà non sono solo i megapixel ma anche la capacità degli stessi di catturare informazioni, la superficie coperta che offrono la qualità effettiva dell’immagine catturata, ma il concetto è troppo complicato, quindi per la massa + megapixel = + qualità.

ricordo ancora quando regalai a mia sorella una compatta da tre megapixel, in un mondo in cui ne erano già uscite diverse da 5-6 megapixel, ma le fotografie e il dettaglio di quelle fotografie era inarrivabile dalle equivalenti come fascia di prezzo, perchè alcune interpolavano, altre avevano si più recettori ma meno sensibili etc etc.

oggi una gara nelle fotocamere e telecamere è la sensibilità (in realtà anche 25 anni fa, visto che si parla anche allora di riprendere con una candela).

Se non si riprende al buio, e non parlo di luce naturale, ma di buio, allora la camera non è degna di nota… quindi una red e una alexa, cineprese digitali con cui fanno i film che hanno una sensibilità nativa di soli 800 iso sono delle scamorze…

Perchè è già tardi comprare un televisore 4k?

diciamo che la mia è una affermazione provocatoria, ma non troppo…

perchè i giapponesi stanno già sperimentando le trasmissioni in 8k, per cui perchè comprare un prodotto superato, tanto vale passare direttamente all’8k 😀

battute a parte, i giapponesi sono sempre stati all’avanguardia con la sperimentazione, ricordo il primo sistema di fullHD ripresa e visione visto di persona al SIM audio Hifi a milano nel 1992, una sperimentazione congiunta tra RAI e un colosso giapponese Ikegami, ironicamente avevo ripreso tali immagini con la mia potentissima vhs a 200 linee e mi sembrava così lontana come qualità e potenza.

ben prima di questi pioneri già nel 1986 Francis Ford Coppola, prodotto da George Lucas, realizzava uno speciale video clip in 4D (3d più quello che oggi si chiama augmented reality) usando telecamere HD sperimentali con protagonista il grande Michael Jackson in Captain EO.

Questo per far presente come se l’HD era già presente come tecnologia nel 1986, oggi dopo quasi 30 anni, ancora non è lo standard televisivo, quindi valutiamo bene quanto il 4k possa penetrare dentro le nostre case in un paio di anni.

Soprattutto si deve riflettere sul fatto che 4k non vuol dire solo cambiare i sistemi di ricezione, poco costosi, ma cambiare tutti i sistemi di messa in onda e trasmissione, e per le televisioni sarebbe un investimento mostruoso, che dubito faranno così velocemente, visto che molte sono ancora alla Standard definition.