Quando nacque la fotografia o la cinematografia, i vari utilizzatori usavano le lenti per la loro espressione artistica e tecnica, ma non si preoccupavano del crop e delle sue conseguenze. Oggigiorno sembra che sia un problema insormontabile e soprattutto drammatico.

Facciamo un po’ di chiarezza sui vari discorsi tecnico pratici.

In fotografia la pellicola ha definito uno standard per gli amatori nelle compatte e nelle semi professionali con il formato 24×36 un formato 2×3, mentre i superprofessionisti usavano il formato dei dorsi 6×9 ovvero pellicole a singola lastra di ben 60×90 mm.

Scorrimento Verticale.

Al cinema la pellicola classica si divideva tra :

- 16mm con un fotogramma di 10.26 x 7.49 mm

- super16mm con un fotogramma di 7.41 x 12.52 mm sacrificando una delle due perforazioni

- 35mm con il formato Academy 16 x 22 mm

- 35mm con il formato 1:85 wide 18,6 x 21.98 mm

- super 35mm con 18,66 x 24,89 mm (che sfrutta tutta la larghezza fino a bordo perforazione)

Scorrimento Orizzontale

Come si può notare pellicola 35mm fotografica e pellicola cinematografica condividono solo la larghezza, ma essendo usati in senso perpendicolare uno all’altra non sono assolutamente comparabili.

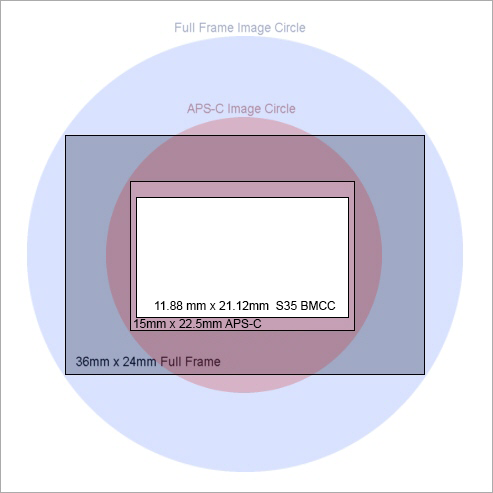

Oggi nel digitale la fotografia ha creato diversi nuovi formati per risparmiare sia sulle lenti che sui sensori.

- Il 24 x 36 è formato standard, è stato rinominato FullFrame

- Il 15,7 x 23,6 è il formato Aps-C, nato nella fascia più economica (che in realtà varia tra le case di qualche mm, ad esempio canon lo riduce a 14,8 x 22,2)

- il 13,5 x 18 è il formato micro quattro terzi creato dal consorzio Olympus e Panasonic e Zeiss

questo significa che il piano focale dove viene proiettata l’immagine da una lente Fullframe (24x36mm) è più piccolo rispetto e questo comporta una serie di cambiamenti estetico-pratici :

- se la lente è più grande del sensore, questo ne prende solo una porzione, quindi l’angolo di visione è più ristretto.

- la luce catturata è inferiore quindi la lente pur essendo veloce (diaframmi aperti) quindi non è in grado di esprimersi al meglio.

- spesso per catturare un angolo maggiore si usano lenti grandangolari più spinte quando narrativamente non andrebbero usate, quindi la prospettiva è più spinta.

Perchè e quando nasce il problema del crop?

Perchè i produttori (sicuramente per scelta economica) che hanno sviluppato le fotocamere e la telecamere preferiscono tenere un unico mount fullframe e poi montare sopra le stesse ottiche sia davanti a sensori fullframe che più piccoli, iniziando a parlare di questo famigerato crop. Tenendo però come riferimento il cosiddetto FullFrame come crop 0, mentre esistendo formati più ampi come il 6×9, in realtà anche il fullframe ha crop, per essere precisi crop 2.4.

Perchè è temuto il crop?

sensore misurato

perchè la maggior parte delle persone teme la moltiplicazione della focale e come tale di perdere angolo visivo, quindi dover spingere maggiormente sull’acquisto di lenti grandangolari più spinte pensando di recuperare l’angolo e tutto sia a posto, solo aver pagato per un grandangolare più spinto.

ma non accade realmente se non ci sono differenze molto molto spinte tra i sensori. Ho scritto un articolo con i confronti diretti tra un sensore 4/3 e un s35 con fotografie di confronto.

Cosa è esattamente il crop? e cosa NON è…

Il crop ritaglia la parte d’immagine SUL piano focale, quindi quando si parla di crop si deve pensare che si prende l’immagine originale e si ritaglia solo la parte centrale; parzialmente influenza la luminosità perchè il cono di proiezione dell’immagine di una lente fullframe non viene preso completamente e quindi dato che i raggi non vengono concentrati in modo convergente, quindi anche se la luce raccolta è X, la risultante sarà X/ la percentuale di crop.

Qual’è errore di pensiero più comune?

Spesso legge, equivalente alla lunghezza focale full frame xxx

ERRORE

Il Crop NON PUO’ CAMBIARE LA LUNGHEZZA FOCALE DI UNA LENTE!!! Non cambia la curvatura delle lenti o la distanza interlente interna, ma solo la parte di piano focale RACCOLTO quindi l’angolo focale.

spesso si legge di lenti tipo 12-35 su formato m4/3 (crop x2) come equivalente di un 24-70 su formato Fullframe… ma non si deve parlare di lunghezza focale, ma di angolo focale.

chiunque pensi che un grandangolare spinto come il 12 e il medio 35 mm possano avere le distorsioni prospettiche di un medio grandandolare 24 e un quasi tele del 70 è un ignorante così grande da non meritare neanche il diritto di scrittura, e invece si leggeva in una pubblicità di Panasonic di qualche mese fa riguardo alla loro ottima lente 12-35 2.8.

Qual’è il più grande errore causato dal crop?

molte persone, tratte in inganno dalla conversione pensano che la moltiplicazione del crop cambi anche la focale e non l’angolo visivo, per cui usano in modo erroneo le lenti e le loro focali.

In fotografia esistono regole ottiche da sempre e non saranno le correzione di post produzione a cambiarle.

Quando si parla di Normali si parla della focale 50mm che si definisce normale perchè corrisponde alla distorsione prospettica dell’occhio umano.

Quando si fotografa con un 50mm si lavora con una lente che se si fotografa guardando con un occhio nel mirino e uno verso la realtà avremo lo stesso tipo di visione.

Esiste una regola molto semplice nella fotografia :

vuoi vedere esattamente come nella realtà? usa il 50mm,

vuoi comprimere le prospettive? sali verso i teleobiettivi.

vuoi dilatare le prospettive? scendi verso i grandangolari.

Il crop ALTERA SOLO l’angolo di visione, ma non può cambiare nè la forma delle lenti interne, nè la loro distanza interasse tra esse.

Alcune case produttrici, come Panasonic, aggiungono una correzione in camera delle immagini per dare l’illusione che l’uso di lenti non adeguate al sensore ma più spinte verso i grandangolari, non creino problemi di distorsione prospettica, peccato che l’algoritmo lavori solo sulla distorsione a barilotto, quindi compensa la distorsione a sfera del supergrandangolare riducendo la distorsione laterale, ma non può alterare la prospettiva, la distanza tra i piani etc, e quindi come tale, si percepisce in modo differente l’immagine.

quindi sia che si fotografi, che si lavori con le immagini in movimento si deve sempre prendere una lente per il risultato ottico prospettico che vogliamo, e solo in casi estremi si va a scegliere una focale più corta solo per catturare una immagine più larga.

quando si usano le ottiche sbagliate i risultati sono evidenti, soprattutto sugli elementi vicini o sui ritratti, dove di solito si usa l’85mm (definita la lente per il ritratto per eccellenza) perchè schiaccia leggermente la prospettiva e rende più piacevole il viso, oltre a sfuocare la parte posteriore per ridurre le distrazioni del background.

Se si usa un grandangolare il viso risulterà deformato e tondo, gli zigomi gonfiati, il naso deformato, per cui il ritratto sarà più caricaturale che naturale. Sulla foto a sinistra basta guardare solo come si spostano gli occhi rispetto al lato del viso.

Se si usa un grandangolare il viso risulterà deformato e tondo, gli zigomi gonfiati, il naso deformato, per cui il ritratto sarà più caricaturale che naturale. Sulla foto a sinistra basta guardare solo come si spostano gli occhi rispetto al lato del viso.

Quindi in definitiva?

quando potete scegliere una focale, lo fate per la sua percezione della prospettiva e non per l’angolo visivo, quindi scegliete i classici 35-50-85-135mm per le diverse situazioni cinematografiche.

Quando si passa per lenti grandangolari più ampie dovrebbe essere una scelta voluta per enfatizzare un determinato effetto di spazio e di prospettiva, non per avere un angolo visivo più ampio.

Non a caso chi fotografa con le lenti prime (focale fissa) si muove per cercare l’inquadratura giusta, e nel cinema è noto che spesso i set hanno le pareti mobili, ma una è aperta per indietreggiare e inquadrare anche attraverso la parete fantasma smontabile.

Ma la profondità di campo con il crop?

Sempre con il crop si teme che con la profondità di campo si vada a perdere, memori delle mezze formato in fotografia o del super8 nella pellicola cinematografica amatoriale, ma sono di nuovo errori dettati dalla superficialità di valutazione. Tutto nasce dal fatto che spesso nei sensori piccoli per gestire l’inquadratura si usano lenti grandangolari di cui si esprime l’angolo focale e non la lunghezza focale, forzando la profondità di campo, quindi è più facile avere tutto a fuoco, e più difficile sfuocare, MA…

NOTA BENE tutto questo accade SOLO quando ragioniamo con l’angolo focale e non con la lunghezza focale.

Infatti chi fa questo tipo di ragionamenti da dimostrazione mostrando fotografie simili fatte con stessa lente con sensori diversi, ma essendoci il crop di mezzo non è fisicamente possibile, quindi il sedicente dimostratore per coprire lo stesso angolo focale si è spostato indietro, ma questo viola la regola del confronto, perchè come tutti i fotografi professionisti sanno, uno degli elementi di gestione della profondità di campo è la distanza del soggetto messo a fuoco, quindi se io ho un crop molto forte di una lente tipo un Nocktor 0.95, e per avere lo stesso angolo focale mi sposto indietro di 5 metri dal soggetto è facile che io vadi in iperfocale, quindi non è il sensore che fa sfuocare meno, ma i principi di ottica tradizionali su cui si basa la fotografia, anche se facesse una foto con una 6×6 avrebbe meno sfuocato.

Per confermare tale discorso posso allegare banalmente qualche fotografia fatta con micro 4/3 (sensore con crop 2) che nonostante quello può esprimere sfuocature notevoli senza problema, perchè è la lente che sfuoca, non il sensore….

-

-

-

35mm 1.4 Samyang

-

-

Lumix 20mm 1.7

-

-

35mm 1.4 Samyang

-

-

Minolta Rokkor 50mm 1.4

-

-

Fiori

Lumix 20mm 1.7

-

-

-

-

-

-

-

E chi dice il contrario?

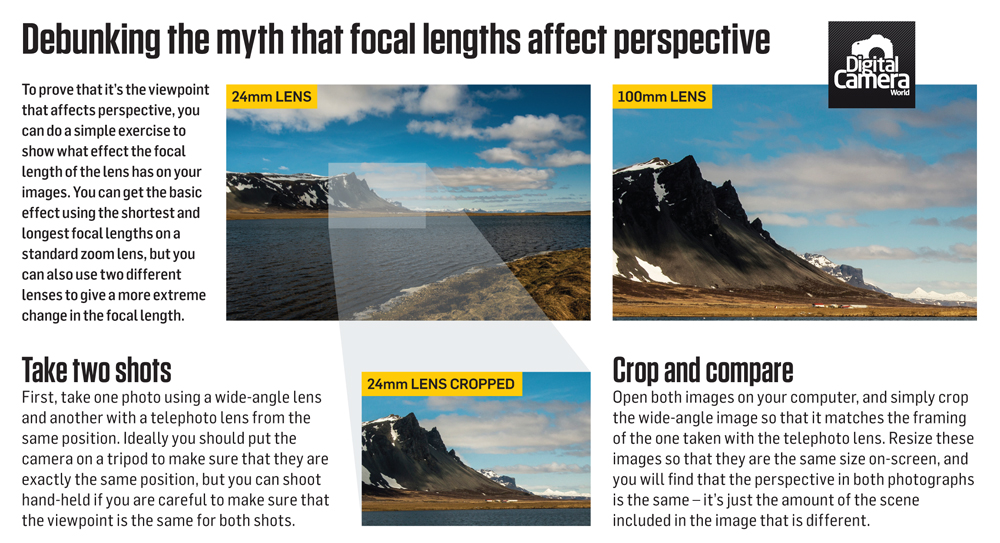

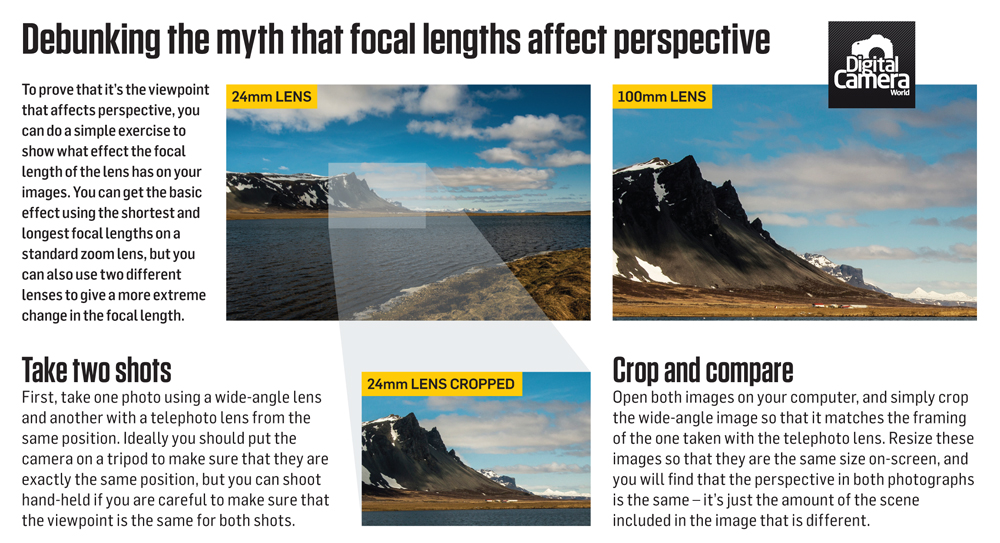

poi vengono fuori articoli, come quello che potete vedere sopra, che pensano di provare il contrario, dimostrando ancora più mancanza di buon senso… prendono una immagine di un panorama fatto con un grandangolare e ne confrontano un elemento moooolto lontano con uno stesso scatto fatto con il tele, e pensano di dimostrare che la distorsione prospettica dipenda non dall’ottica ma dalla posizione barra distanza… mentre il tutto è la somma delle due cose.

tra l’altro prendendo la parte centrale dell’immagine la distorsione è ancora meno evidente e quindi ancor più inutile e falso come confronto. Inoltre non spiegano perchè gli elementi col salire della focale si avvicinano tra di loro…

[ironic mode on] forse perchè se vi allontanate voi si avvicinano tra di loro per starvi più vicini… [ironic mode off]

fate una foto con questo e vi sfido a prendere una qualunque parte dell’immagine e replicarla con un tele, per quanto piccola la prendiate, la curva di raccolta della luce comporta una distorsione talmente forte da non poter essere fatta corrispondere da nessun fattore di compensazione.

comparazione degli elementi da vicino

La distorsione della prospettiva è legata all’angolo che viene coperto dalla lente, quindi dalla forma stessa, maggiore è la curvatura, maggiore è la dilatazione della prospettiva, per cui è normale che se si prende con un grandangolo un elemento lontanissimo esso copre un angolo così stretto della lente che la distorsione prospettica è ridotta o nulla. Ma questo tipo di dimostrazioni non le fanno, perchè non possono, con elementi più vicini al corpo camera, quindi dove si sente una differenza più forte.

Inoltre sfido questi sedicenti esperti a replicarmi con un grandangolare il riposizionamento degli elementi sui piani come i rami dietro la ragazza nella seconda fotografia semplicemente spostando il punto di vista.

Inoltre sfido questi sedicenti esperti a replicarmi con un grandangolare il riposizionamento degli elementi sui piani come i rami dietro la ragazza nella seconda fotografia semplicemente spostando il punto di vista.

Troppo spesso queste affermazioni sono fatte trovando una eccezione alla regola delle focali come le riprese molto distanti degli elementi, dove le caratteristiche differenti tra focali corte e lunghe si riducono, basta prendere elementi vicini qualche metro… e si nota subito come sia impossibile ottenere lo stesso risultato.