Abbiamo abbastanza qualità per i nostri progetti?

Dopo aver cambiato tanti mezzi di ripresa sono approdato ad un prodotto che mi permetterà per qualche anno di lavorare tranquillo, anche ad alto livello. La cosa curiosa è proprio che mentre mi sono stabilizzato con questo mezzo, ho letto tutta una serie di articoli relativi ai vari camera’s peeper che nell’attesa della fantomatica nuova macchina, deprecano cosa possono avere per le mani, prodotti ottimi per raccontare una storia.

Dopo aver cambiato tanti mezzi di ripresa sono approdato ad un prodotto che mi permetterà per qualche anno di lavorare tranquillo, anche ad alto livello. La cosa curiosa è proprio che mentre mi sono stabilizzato con questo mezzo, ho letto tutta una serie di articoli relativi ai vari camera’s peeper che nell’attesa della fantomatica nuova macchina, deprecano cosa possono avere per le mani, prodotti ottimi per raccontare una storia.

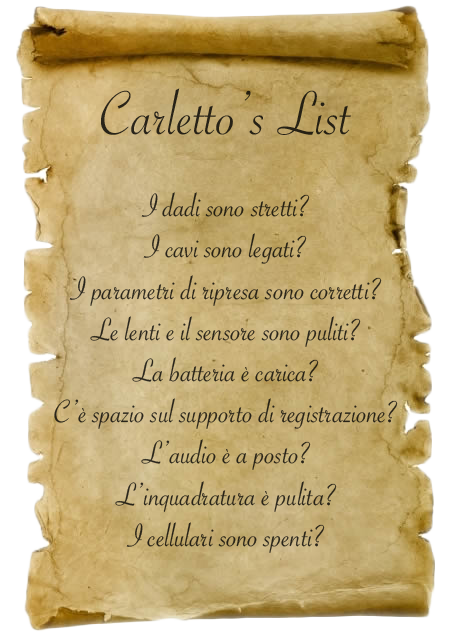

Esiste un termine in inglese coniato da Stu, Next camera disorder, che rappresenta bene il concetto : non posso lavorare con il mio attuale strumento, perchè quello che sta per uscire è meglio… non devo sprecare tempo ora con la mia camera/reflex/cinepresa, perchè otterrei risultati di qualità non sufficiente.

Oggigiorno sembra che la prossima camera che si comprerà sarà sempre migliore, più risoluta [8k], più sensibile [Sony A7 series], Modulare quindi sarà la definitiva [Axiom], più professionale [cinepresa XXX scegliete voi], quindi si procrastina con la storia…

Oggigiorno sembra che la prossima camera che si comprerà sarà sempre migliore, più risoluta [8k], più sensibile [Sony A7 series], Modulare quindi sarà la definitiva [Axiom], più professionale [cinepresa XXX scegliete voi], quindi si procrastina con la storia…

Ammetto che comprendo la perplessità di alcune persone, di fronte a mille offerte e ad un mercato in continua evoluzione, ma non comprendo la pigrizia… Si vogliono macchine sempre più automatiche e perfette, dove fanno tutto loro, e che costino poco poco, ma allora dove sta l’arte e l’abilità nell’usarle se fanno tutte le cineprese/telecamere/macchine fotografiche?

Non a caso si vedono un sacco di immagini patinate, tutte molto simili, con lo stesso movimento di slider, con gli stessi filtri di post, le stesse lut… le fanno le macchine, [mod provocazione On] quindi i creatori diventano intercambiabili e si possono pagare anche poco, tanto uno vale l’altro [mod provocazione Off].

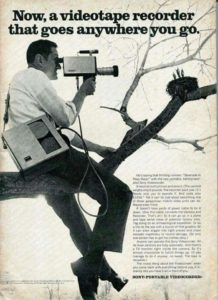

Senza diventare noiosi, la prima camera che ho usato nel 1990 (si comincio ad essere un master) era una vhs spallare, e la risoluzione effettiva era di circa 200 linee, quindi se avessimo acquisito il materiale digitalmente al max della qualità l’effettiva risoluzione (interlacciata) è circa 320×200 pixel, poi l’acquisizione da vhs decente con tbc si può fare in pal, ma non vedreste nessuna differenza di qualità e nitidezza. Il montaggio si eseguiva facendo almeno un paio di copie [degrado analogico forte] durante il montaggio, e quello diventava il master, che poi veniva duplicato per mandarlo ai rari festival che accettavano vhs 25 anni fà… Eppure la gente con il vhs e 8mm (nastro digitale) girava comunque cortometraggi.

un esempio molto interessante è questo cortometraggio che ha lanciato Robert Rodriguez, e che gli ha permesso di essere conosciuto da molte persone, compreso Quentin Tarantino che vide la brutta copia della copia della copia di questo VHS.

Poi passai con un grande salto ad una MiniDv, dove la risoluzione era realmente 720×576 pixel, molto sporchi [sensibilità intorno ai 800 iso tirata max] e contrastati, e interlacciati. Ma comunque questo non ha impedito la realizzazione di storie, da li poi un salto all’HDV progressivo 1440×1080, e il full HD con le tre ccd e poi le mirrorless panasonic. Butto li qualche cifra di pixel pur sapendo che sono termini relativi, nel mio articolo relativo alle risoluzioni ho fatto una disamina più precisa su quale sia la differenza tra la risoluzione apparente e reale, e come il numero di pixel non sia il reale indicatore di qualità di un prodotto.

Con le mirrorless ho ritrovato il piacere di usare obiettivi a fuoco manuale, il controllo manuale e reale dei diaframmi della camera, lavorare con ottiche fisse, ho usato telecamere che avevano solo metà dei diaframmi dichiarati, mentre oltre una certa cifra i diaframmi erano emulati dall’uso di un filtro neutro che toglieva luce, non cambiando la profondità di campo (e spesso introduceva una dominante verde… mannaggia ai progettisti daltonici).

Oggi sono su una macchina che produce dal fullHD registrato con prores Proxy alla qualità più scarsa fino al 4k raw quando si ha bisogno del massimo della qualità e della flessibilità in post produzione, il tutto con qualche vincolo, perchè nascendo come cinema camera nasce è stata pensata per usi di un certo tipo, per persone che sanno come riprendere e postprodurre il materiale in un certo modo, ma è esattamente quello che cercavo, perchè mi offre il controllo che volevo e una qualità di gran lunga oltre quello che mi serve oggi (con la precedente camera ci hanno girato inquadrature di Madmax, diciamo che con questa si può anche fare di più).

Ognuno di noi ha una sua idea della qualità, poi però la pubblicità, le immagini luccicanti delle pubblicità ci possono far cambiare idea.. forse… o forse sono pensate per farci pensare che non abbiamo abbastanza.. una delle basi della cultura moderna del marketing, far credere di non aver abbastanza per far comprare il superfluo, sempre. Ho scritto una riflessione sul 4k oggi, proprio in funzione dell’inutilità di avere il 4k in tv, sui cellulari e sulle camerine amatoriali.

I miti della qualità

ora stacchiamoci dai sentimentalismi e cerchiamo di capire cos’è realmente la qualità, reale o percepita. quando si osserva una immagine noi percepiamo prima la luminosità e poi il colore, tramite la luminosità percepiamo il dettaglio, la profondità e le distanze tra gli elementi, poi il colore ci fornisce informazioni aggiuntive sugli elementi; questo principio non è digitale, ma analogico, perchè sono così che funzionano gli occhi dell’essere umano, coni per il colore e bastoncelli per catturare la luce, questi ultimi essendo più numerosi e attivi per catturare luce e movimento forniscono il vantaggio.

quindi analizzando una immagine in movimento cosa possiamo indicare come qualità?

- la risoluzione dei dettagli fini, quindi poter vedere ogni elemento possibile.

- la capacità di fornire dettagli e informazioni sia in ombra che in luce, come fa l’occhio umano che ha una gamma dinamica molto ampia

- dei colori percebili NON troppo accesi, perchè se troppo accesi alterano la percezione delle sfumature, e comunque l’occhio umano percependo prima la luminosità e poi il colore, in una immagine troppo satura percepirebbe meno dettaglio, quindi la ritiene meno ricca.

- riproduzione corretta del movimento veloce, quindi non troppo nitido altrimenti diventa stroboscopico, non troppo mosso, altrimenti diventa illeggibile.

beh in teoria questi sono elementi oggettivi per determinare la qualità, ma basta andare in un centro commerciale e vedere come le persone percepiscano come migliore quello che è l’esasperazione di questi elementi, colori accesi tanto da perdere tonalità perchè vanno in solarizzazione, contrasti e maschere di contrasto esasperati per mostrare una “incisione” di dettaglio che non esiste, ma creando una specie di finto basso rilievo danno l’illusione di tale elemento visto da lontano, funzioni infernali che tolgo e aggiungono la sfuocatura di movimento in funzione della follia dell’ingegnere che ha progettato quei circuiti, convinto che il “SUO” gusto visivo sia quello da imporre al resto del mondo, sicuramente nel 90% non disabilitabile, e così via… tanto da trasformare le immagini cinematografiche in specie di telenovelas brasiliane anni 90…

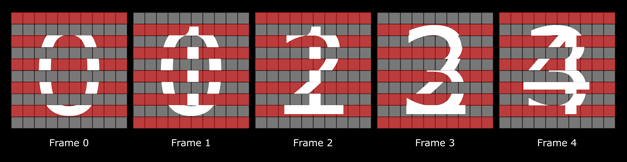

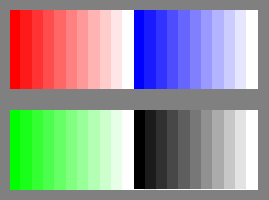

qualche dubbio? bene guardate bene questa PNG, dove ci sono tacche a stacchi di 10 toni tra un colore e l’altro e tra una luminosità e l’altra, a seconda del vostro monitor e della calibrazione applicata, appena voi andate a toccare la saturazione perdete i primi toni da sinistra, ovvero dal 30 al 40% delle sfumature colore della vostra immagine.

qualche dubbio? bene guardate bene questa PNG, dove ci sono tacche a stacchi di 10 toni tra un colore e l’altro e tra una luminosità e l’altra, a seconda del vostro monitor e della calibrazione applicata, appena voi andate a toccare la saturazione perdete i primi toni da sinistra, ovvero dal 30 al 40% delle sfumature colore della vostra immagine.

Stessa cosa vale per la luminosità dove le parti più scure vanno a perdersi.

Poi ci sono quelli che dicono, si va beh quando visualizzo una tabella di colori, di solito ho immagini ricche di colore…

osservate questa immagine, alzando la saturazione perdiamo due cose fondamentali, il dettaglio tra i pistilli, perchè tutte le sfumature minime diventano uguali e quindi si appiattiscono, e il colore vero, perchè in origine il fiore è tra il rosso e il lilla, ma alzando la saturazione, il blu è già al massimo, quindi alzandosi il rosso si perde l’equilibrio originale, trasformando un colore in un altro.

A dimostrazione che sbagliano quelli che dicono che alzando la saturazione, avendo colori più brillanti otteniamo colori più naturali, dato che accade esattamente il contrario.