Molto spesso si investe in attrezzature molto costose, mentre alle volte si trascurano piccoli elementi che possono cambiare la nostra vita in meglio, o salvare i nostri progetti in emergenza…

molto spesso le batterie sono oggetti che viaggiano sparsi nelle borse, nelle scatole, e non si sa mai se sono cariche o no. Acquistare un paio di set di due colori di queste custodie significa poter tenere in ordine le batterie, i diversi contenitori si possono attaccare tra di loro e usando un colore per le cariche, uno per le scariche diventa molto semplice e rapido tenerle organizzate sul set.

2) Protezione per Hard disk 7 €

2) Protezione per Hard disk 7 €

Spesso si utilizzando hard disk per il backup direttamente in loco, ma non potendo usare sempre e solo Hard Disk di tipo rugged, un piccolo investimento in protezione si può fare, e può salvare da piccole cadute o urti accidentali.

Spesso durante le riprese ci si ritrova col dover svitare delle viti da piastre o da attrezzature, e non abbiamo a portata di mano lo strumento adatto, col passaggio all’euro non tutte le monete sono adatte, per cui ritengo che sostituire le viti classiche con queste con ala apribile può aiutare molto i cambi al volo.

L’unica cosa prendete bene le misure delle lunghezze delle viti per far fare bene la presa.

4) tappi in silicone hdmi 6 €

4) tappi in silicone hdmi 6 €

Se si lavora con prodotti video spesso si hanno tante porte aperte a polvere, e altri detriti che vi daranno problemi al momento sbagliato, quindi investire un poco per avere dei tappi in silicone per chiuderle è un’ottima idea. Ne esistono di diversi tipi per diverse porte, comprarne un sacchetto è la scelta più economica per evitare di portare in assistenza la camera dopo una sessione su pista o peggio trovare falsi contatti al momento sbagliato.

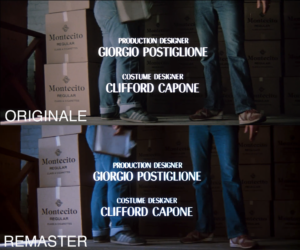

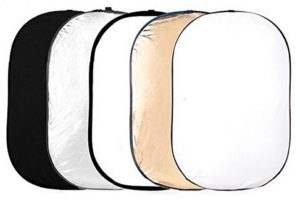

5) Diffusore e riflettore 100×150 30€

5) Diffusore e riflettore 100×150 30€

Spesso possiamo non avere abbastanza luce o la luce giusta, questo oggetto poco ingombrante ci permette di riflettere la luce, addomesticarla, usare una sola lampada e rifletterla, etc

6) Target per bilanciamento del bianco, esposizione e fuoco 12.99€

Un semplice e poco ingombrante pannello per bilanciare il bianco, verificare l’esposizione con il grigio al 18% per l’incarnato, e un semplice target che vi aiuta a verificare il fuoco.

7) Gomma Crepla xx €

7) Gomma Crepla xx €

In mezzo a tanta tecnologia spesso ci sono delle mancanze banali a cui la tecnologia non può porre rimedio, una di queste sono i monitor poco luminosi, ma soprattutto mancanti di paraluce, o con piccoli paraluce. La gomma crepla è una morbida e semplice gomma morbida, economica e semplice da tagliare e dargli forma.

Crearsi un paraluce per ogni tipo di monitor è questione di pochi minuti, e in caso di danni se ne possono creare più di una, in modo da avere i ricambi.

8) Penna per tablet 9 €

8) Penna per tablet 9 €

Una banalità contro la quale sono colpevoli tutti i progettisti e i deSAIGNER del mondo… monitor touch LUCIDI… quelli che siete costretti ad usare per attivare molte funzioni, ma che si riempono di ditate, di sporco, e sotto luce forte (sole) i riflessi e lo sporco vi impediscono di vedere bene le immagini. Prendere una semplice penna da tablet vi permette di attivare e controllare le varie funzioni senza sporcare il monitor, o nel momento in cui avere un paraluce più ingombrante per vederci bene col sole potete cambiare le funzioni comodamente.

9) Viti fotografiche in generale

9) Viti fotografiche in generale

molto spesso i filmaker si ritrovano con la necessità di collegare, unire, fissare tool alle cage, e le viti filettate da 1/4 e da 3/8 di pollice con passo fotografico (tecnicamente sono viti in pollici UNC (passo grosso americano) sono spesso costose e difficili da trovare. Ho avuto la fortuna di conoscere e fornirmi da una azienda molto preparata e ben fornita, https://www.novarametalli.it, che forniscono varii tipi di viti e passi, tra cui quelli fotografici.

Il link di base da cui partire è Viti fotografiche, poi a catalogo hanno migliaia di varianti. Sono professionali, precisi e velocissimi nella spedizione.

10) MultiTool cubico

10) MultiTool cubico

questo oggetto è qualcosa di molto particolare, che se vi serve sarete felici di scoprirlo, perchè quando siete a corto di fori di montaggio nel vostro rig, questa è una delle soluzioni 😀 Il cubo!

11) adattatore per filtro 4×4 per mattebox

|

Questo è uno di quegli oggetti geniali che se non li avessero inventati dovrebbero farlo. Avete comprato o affittato un mattebox 4×6.5 pollici, perchè più largo fa più “cinema” ma avete tutti i filtri 4×4, e avete paura che cadano a terra. Questo economico pezzo di metallo e plastica fa da Holder ai filtri 4×4 e si mette a misura dentro il portafiltri 4×6.5. |

Basta poco per essere pronti a sfruttare tutti i vostri filtri 4×4.

Basta poco per essere pronti a sfruttare tutti i vostri filtri 4×4.

e questa pagina potrebbe continuare all’infinito, e così sarà, l’idea è aggiungere man mano che scopro o trovo oggetti utili per il nostro lavoro.

1) Custodie per batterie 7 €

1) Custodie per batterie 7 €